大家好,我是程序员晓晓

AI视频重绘,在当下大家并不陌生。我们的实现方式大致可以分为三种:

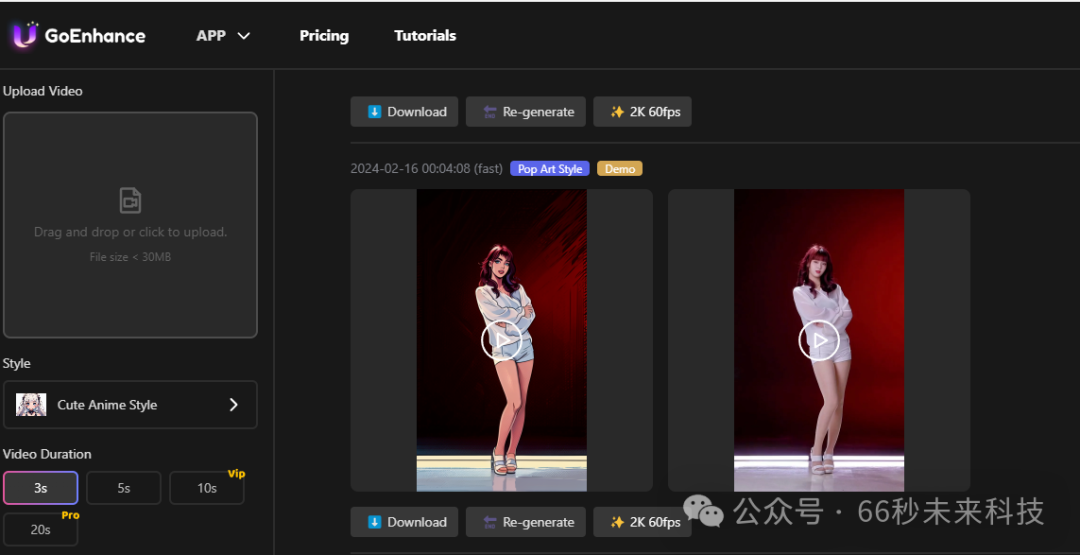

第三方平台和discord上转绘,如DomoAI ,GoEnhance AI 等。

优点:效果佳,门槛低。

缺点:需要科学上网,和支付一定的使用费用。

ComfyUI转绘工作流,通过animateDiff 结合CN控制网生成视频。

优点:本地部署,可控性高,根据自己的配置灵活取舍。

缺点:门槛高,安装麻烦,需要下载大量的模型。

SD-WebUI通过TemporalKit和EbsynthUtility插件插件生成视频。

优点:本地部署,不需要网络。

缺点:门槛中,操作也很多。

那么我们今天就详细地讲解一下SD-WebUI下重绘视频的详细生成步骤,如果你也想生成AI视频转绘高清视频,请继续往下看。

测试的视频资源我用的是GoEnhance.Al 官方上的视频。

如何使用:

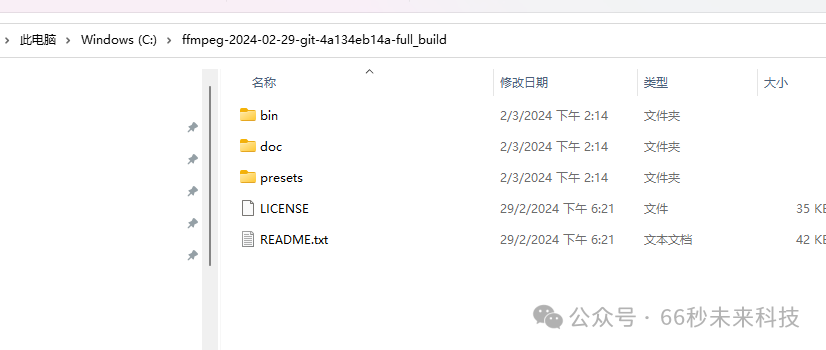

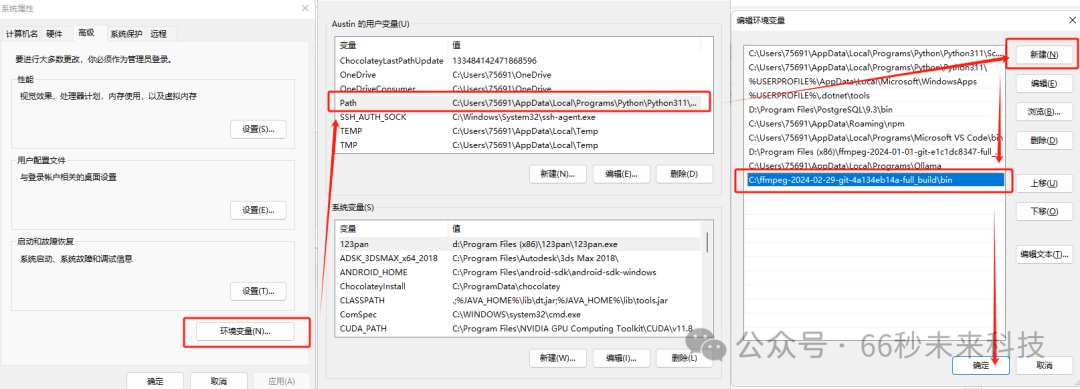

1. 安装ffmpeg:

下载ffmpeg软件包,将其解压到C盘。

然后将其完整路径添加到系统环境变量,注意是bin目录。

然后我们可以“win+r” 输出“cmd”

调出控制台输入“ffmpeg -version” 出现详细信息就表示ffmpeg安装成功。

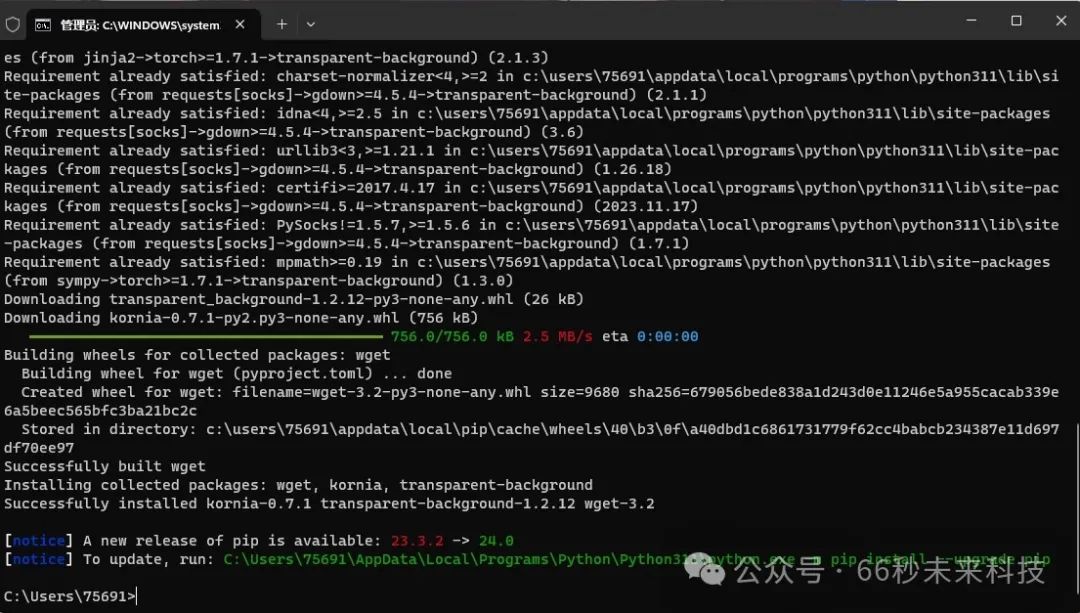

2. 安装transparent-background:

在开始“运行” 输入“cmd” (或者键盘Win+R,输入“cmd”)

在弹出的命令行里面输出“pip install transparent-background”

等待输入提示符闪烁,安装完成。

3. 安装SD插件:

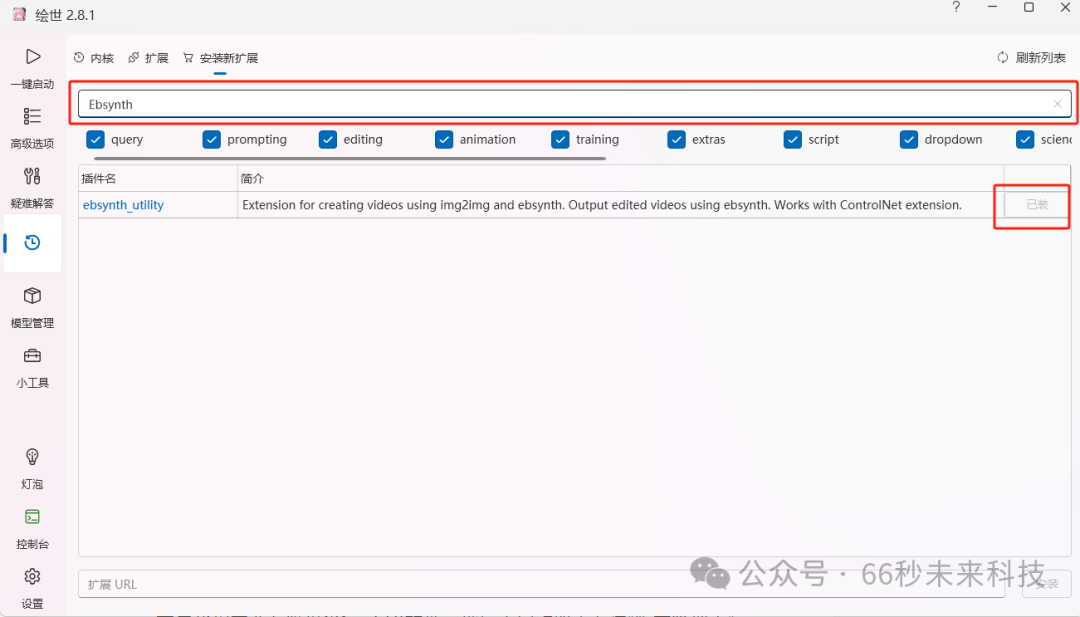

首先我们需要有绘世SD webUI软件(如没有AI绘画软件SD,请看文末扫描获取),然后双击启动“A绘世启动器.exe”,在启动器面板左边“版本管理中”找到“安装新扩展”

搜索一下“Ebsynth ” 点击后面的“安装”,(如无法安装,请看文末获取本地插件安装包)

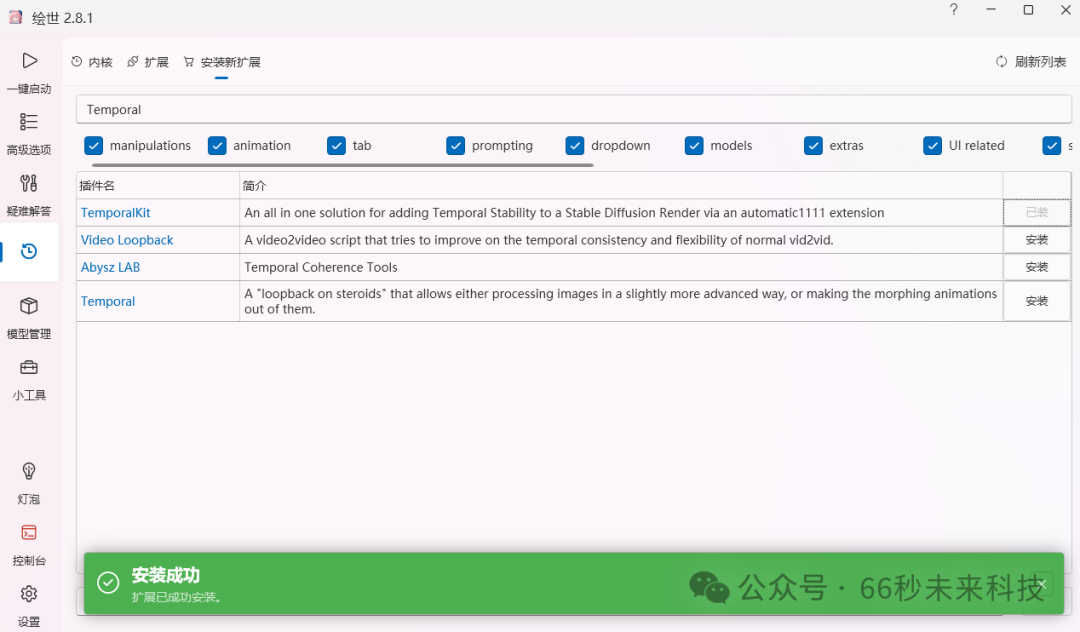

再搜索“Temporal” 点击安装。(如无法安装,请看文末获取本地插件安装包)

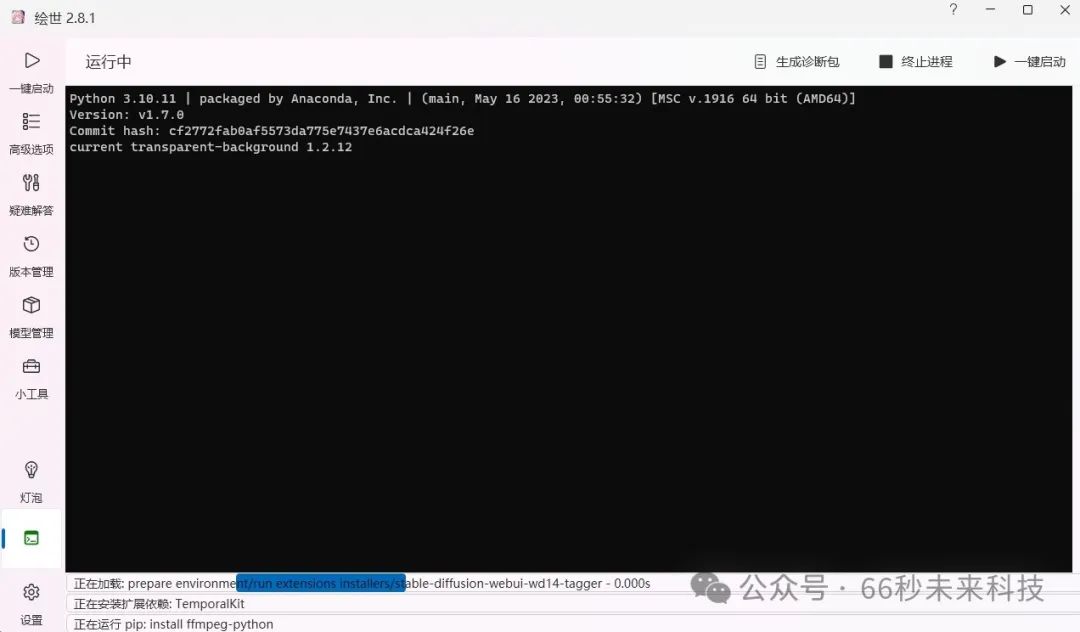

然后我们来到首页点击“一键启动” ,启动SD-WebUI。

它会自动下载安装插件,安装完成后会自动弹出URL网页链接。

此时我们需要的插件和环境都安装完成了,接下来看看如何使用。

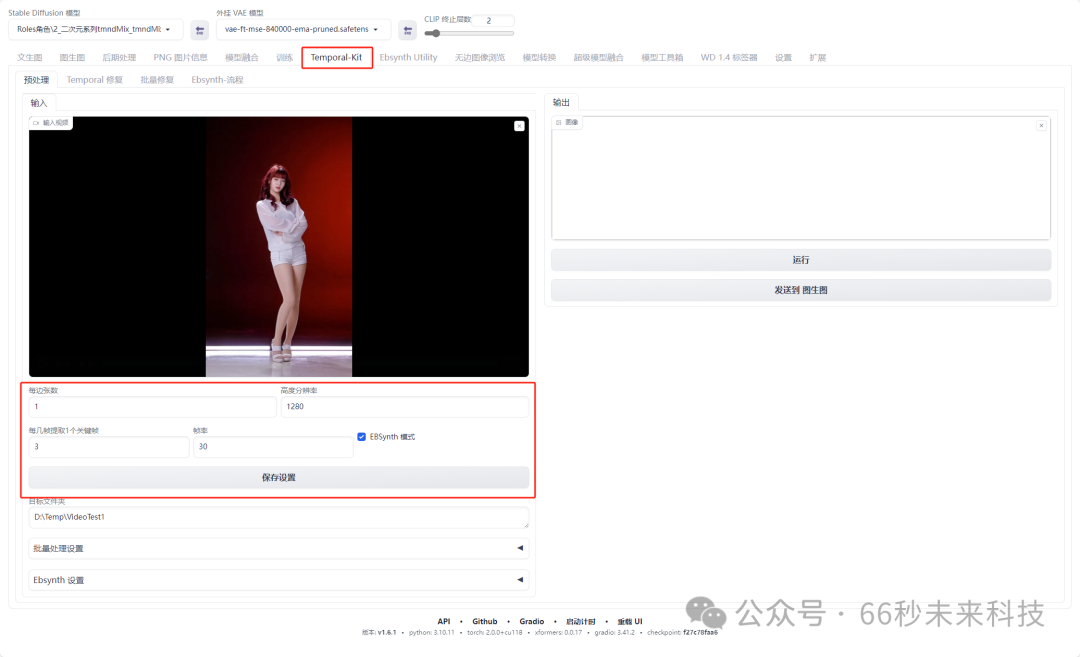

4. 分割视频:

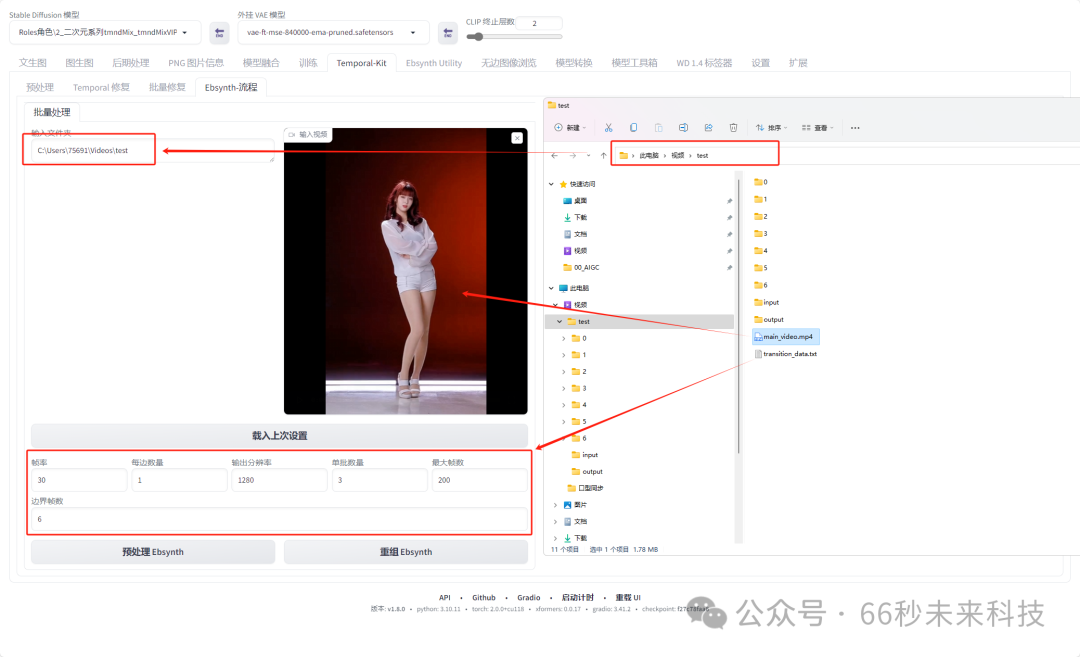

首先,我们找一个要转绘的视频,将其拖拽入WebUI中。设置如下,每1帧都采样,动作幅度较大就设置成每3帧提取一个关键帧。

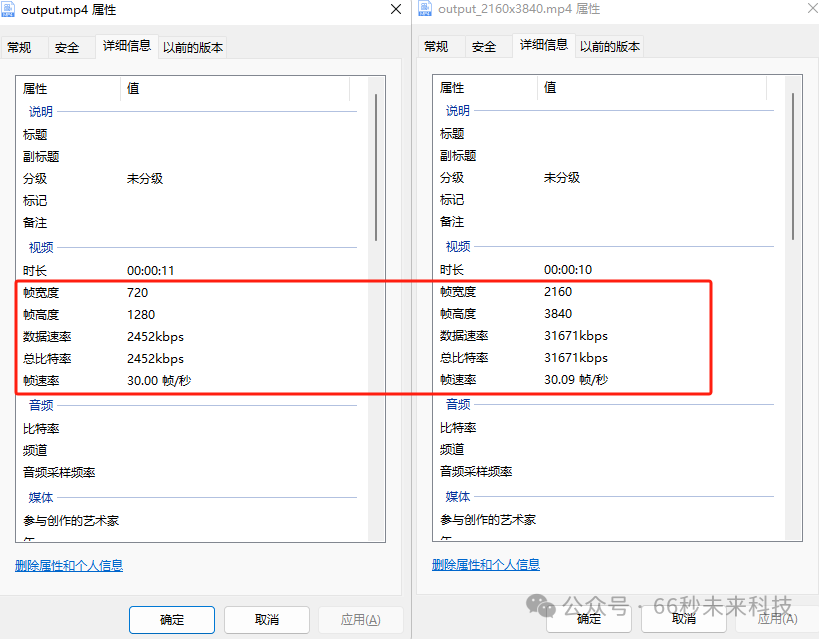

分辨率我们可以在视频上右键“属性”-详细信息中查看,填写入视频的高度点击“保存设置”。

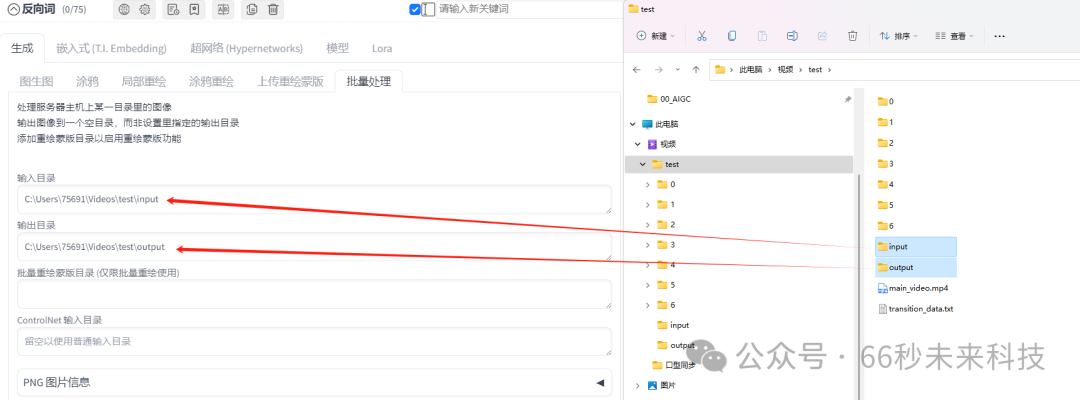

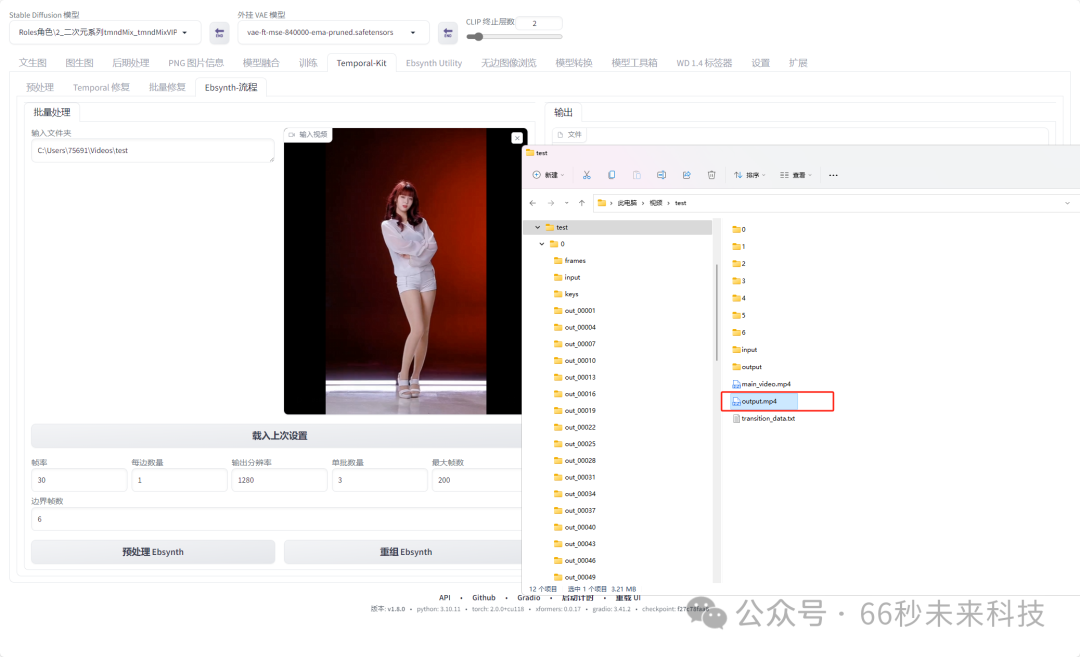

然后,我们需要在本地任意地方创建一个纯英文路径的文件夹。我在C:\Users\75691\Videos\test创建了个文件夹用于接收渲染的文件。

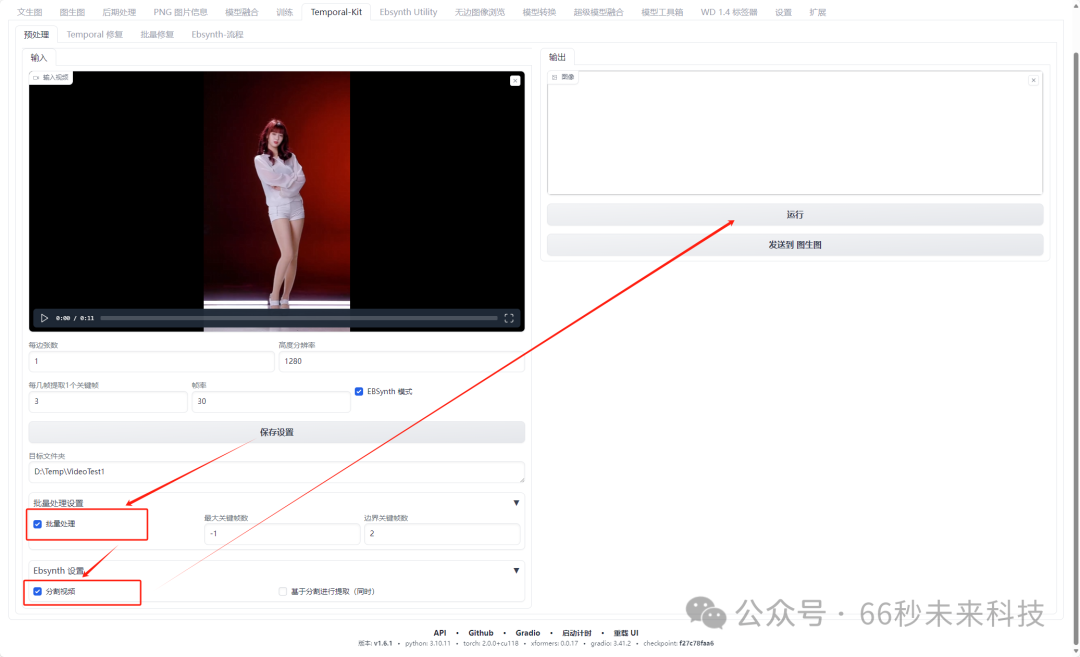

将这个路径填入设置,勾选“批量处理” 和“分割视频” 选项,然后我们就可以点击右边的“运行”了。

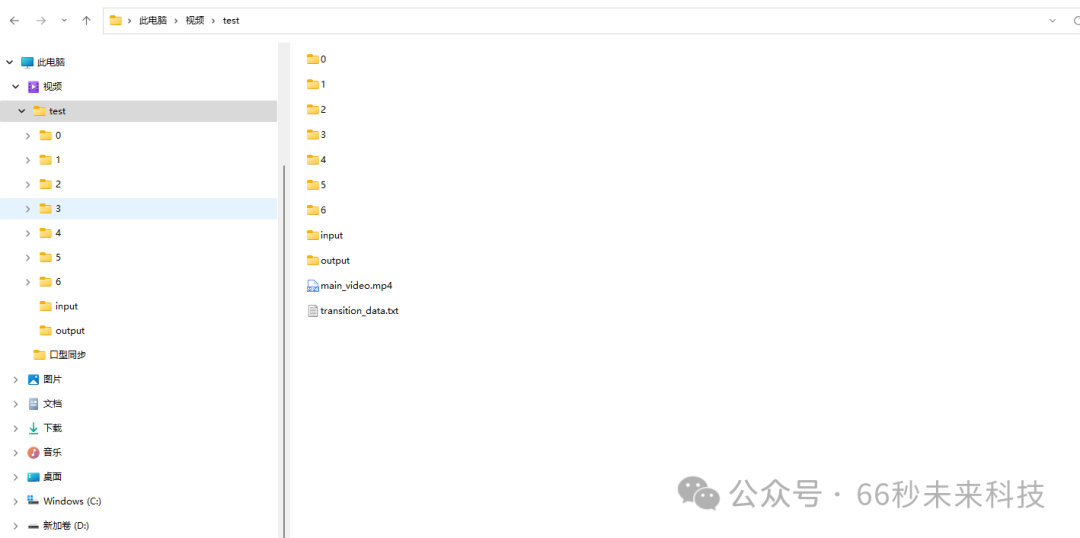

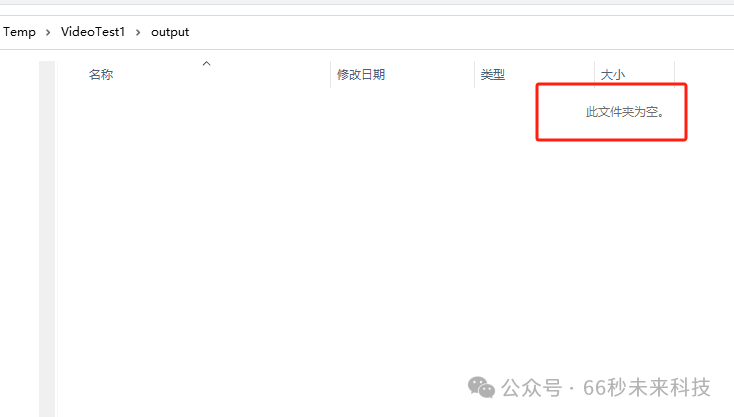

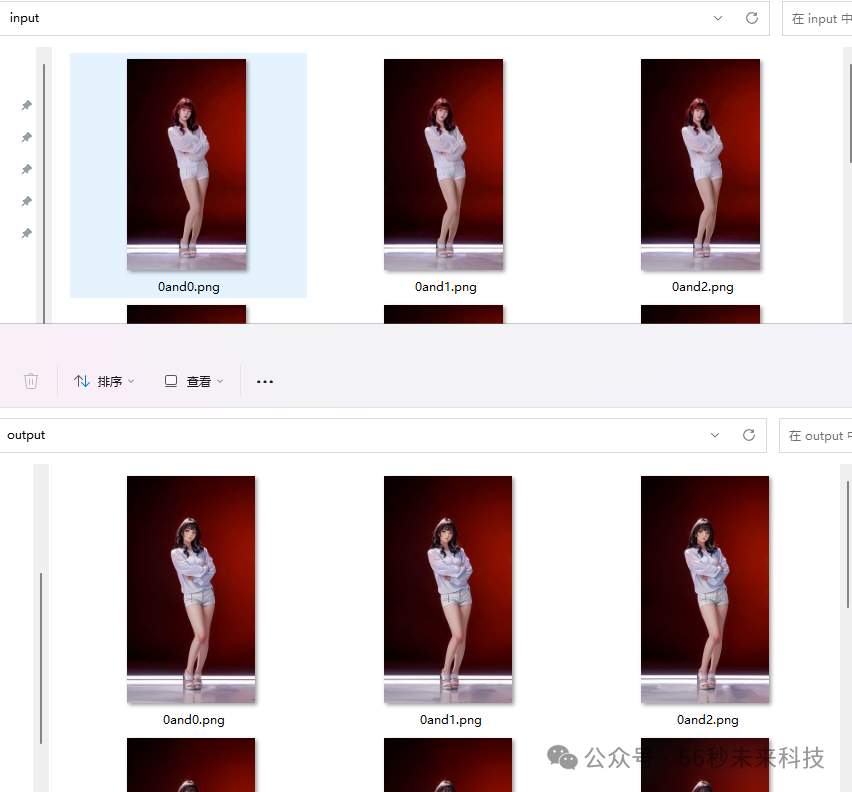

我们会看到刚创建的目录下面,会存放分割的视频文件图片。

0~6是刚刚每隔3帧取一个关键帧的储存文件夹。

input是原始视频逐帧图存放的文件夹。

output是一会儿要重绘的图的存放文件夹。

main_video.mp4是原始视频文件。

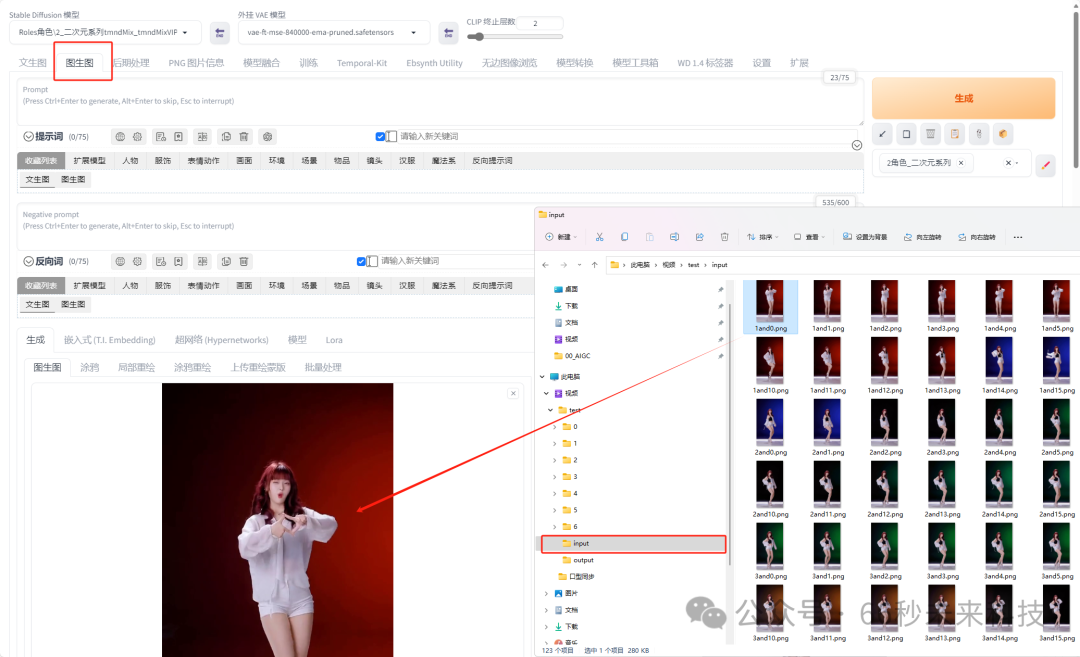

5. 确定风格:

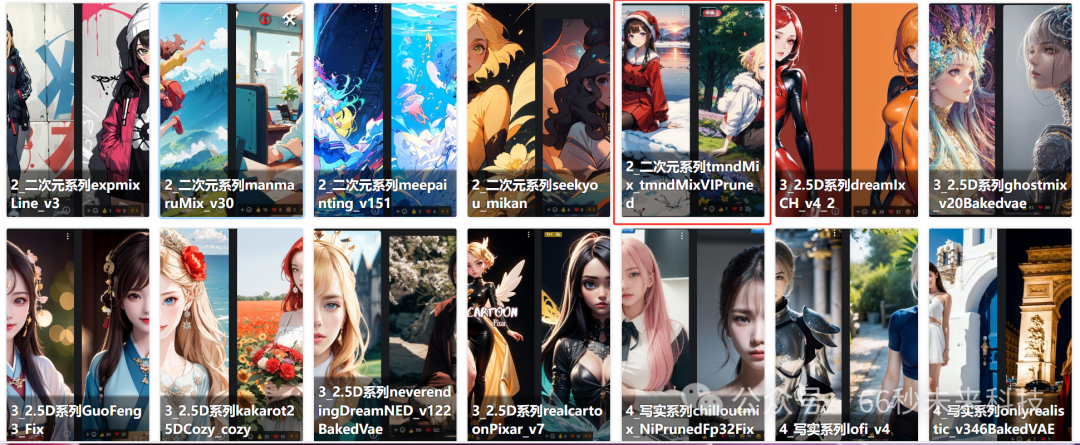

然后我们需要确认我们转换的风格,比如是转换成卡通,还是3D又或者是真人,这些取决于我们选择的大模型的风格。我们这里选择卡通二次元。

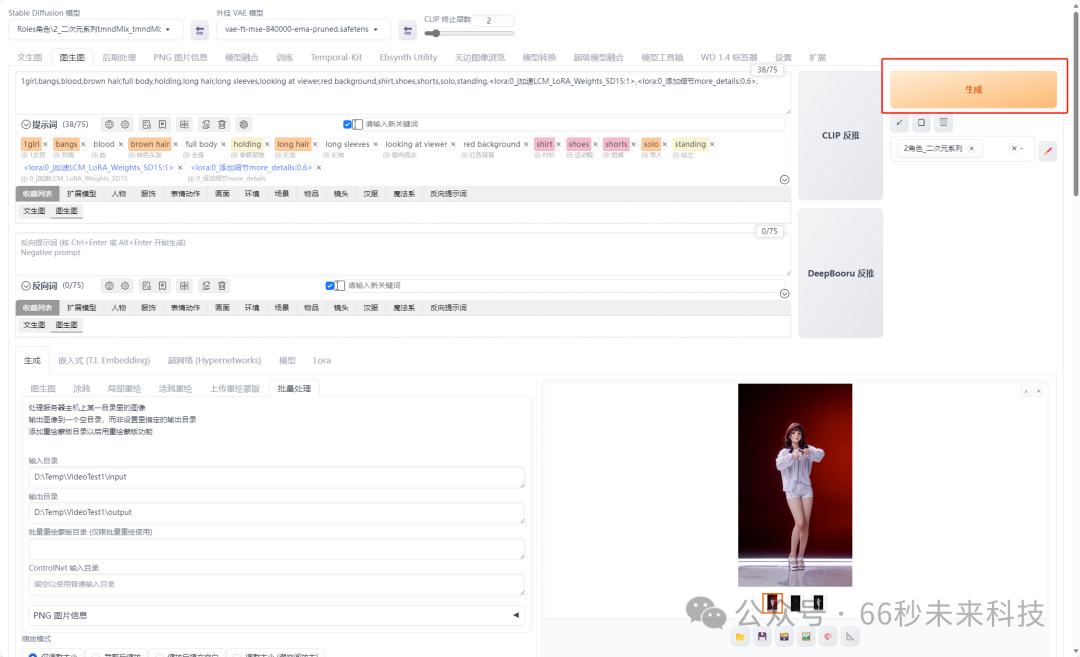

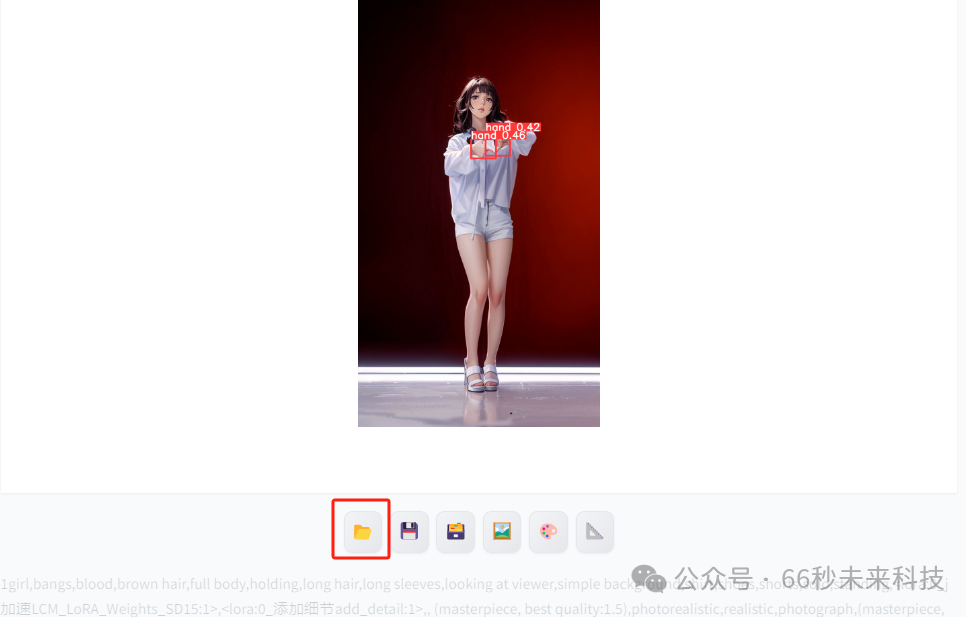

将刚刚input路径下的图片拖入图生图,跑图测试。

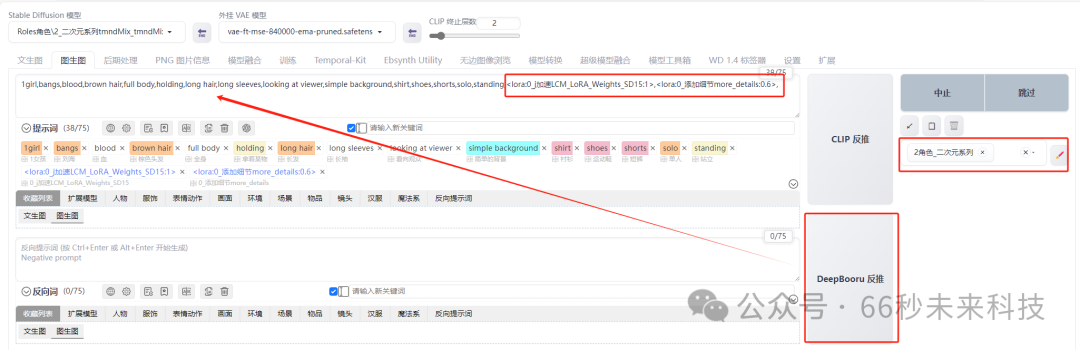

修改提示词,先用DeepBooru 反推提示词。将红色背景,改成简单背景。加入LCM加速,提升出图速度。(我还加了个添加细节的lora这个随意)选择一个二次元模板。

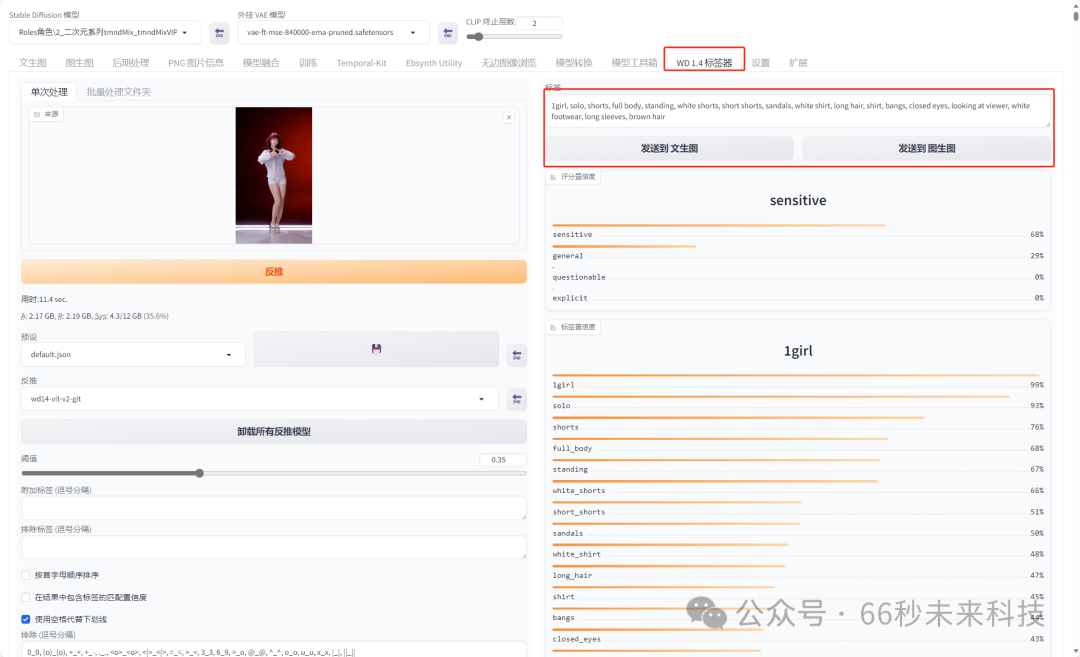

如果你没有DeepBooru ,也可以用“WD 1.4标签器”反推提示词。

随后,我启用了“ADetailer”用于面部和手部修复。

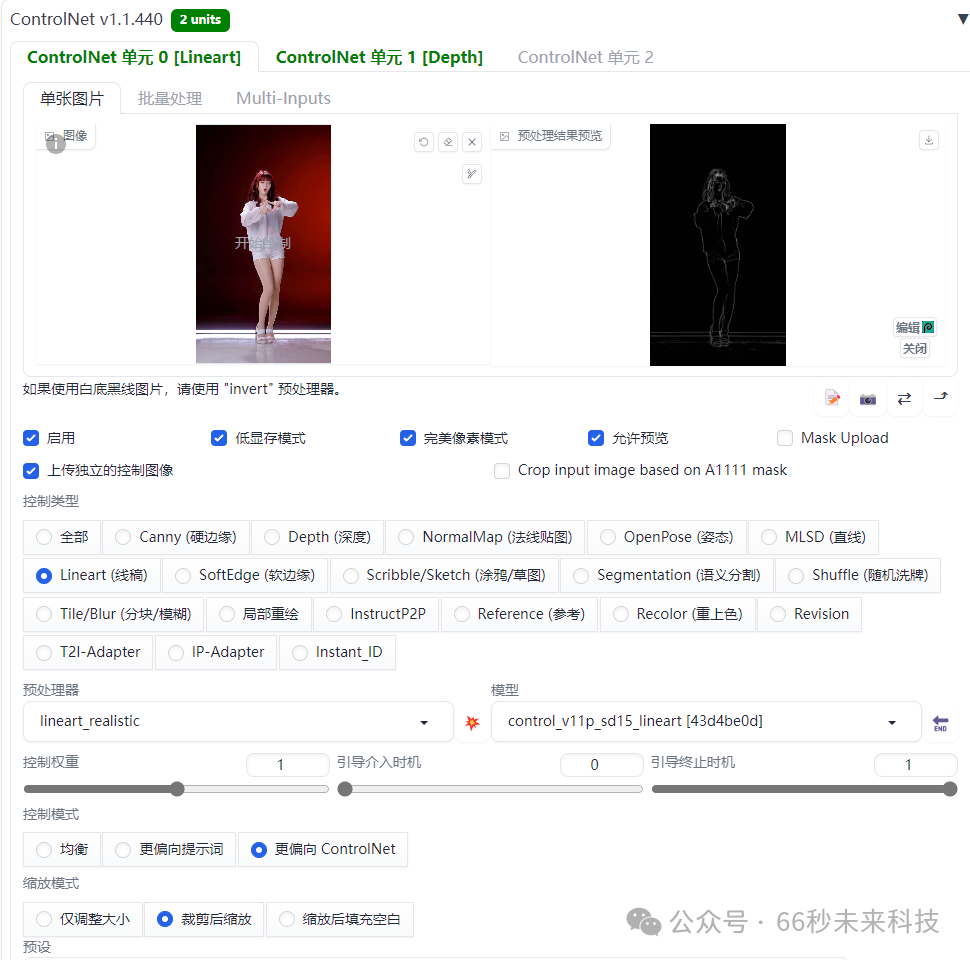

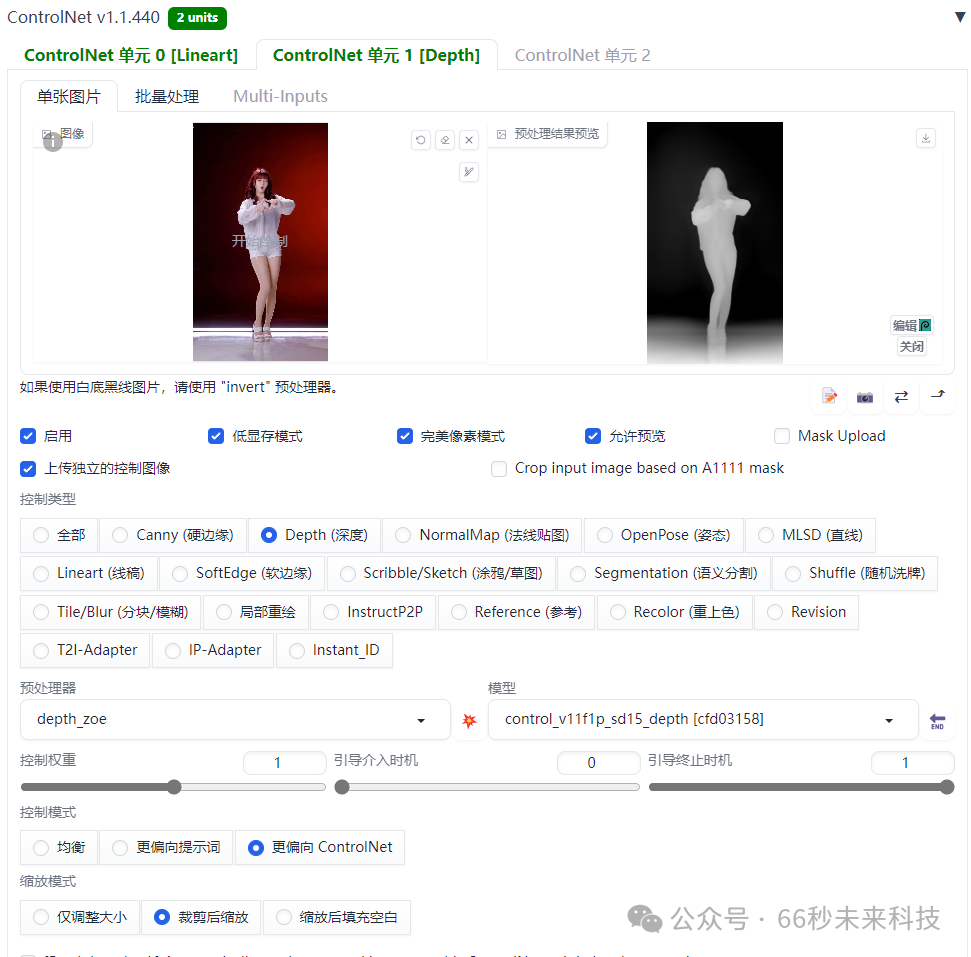

加入了ControlNet 设置了两个单元,分别控制形态和前景。

渲染确定风格,这里风格主要取决于我们选择的大模型。

比如我选择的是tmndMix,你也可以选择写实的麦橘,那样出的风格就是写实的啦。

6. 批量渲染:

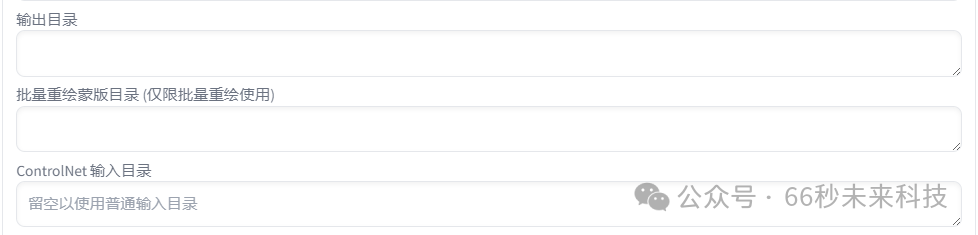

我们来到图生图的窗口,点击“批量处理”,将之前的输入输出目录的路径填入其中。

接下来,再将下面的“ControlNet ”的“批量处理” 页签打开,路径不用填写,它会继承图生图的路径设置。

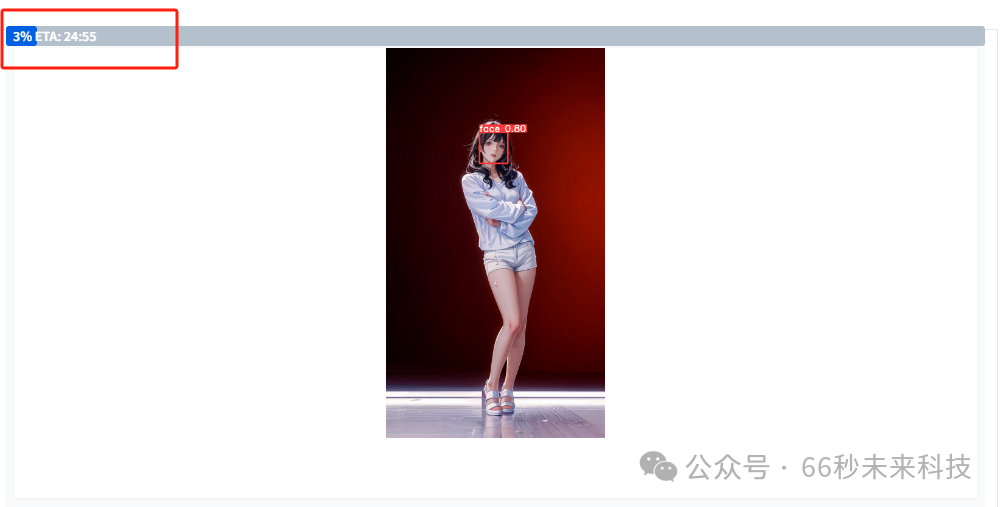

注意上面是两个“ControlNet ”都要设置,完成后我们就可以点击“生成” 按钮了。

因为有lcm加速,所以速度要比以前快很多。显示大约需要的时间。

补充:这里有个bug注意一下,就是输出目录output填入了显示正常,但是跑图的时候无效。

我们会看见后台正常在跑图,但是填写的路径下目录里没东西。这时候我们需要“终止” 渲染。

将输出目录的地址清空不填写地址,用sd默认的地址。

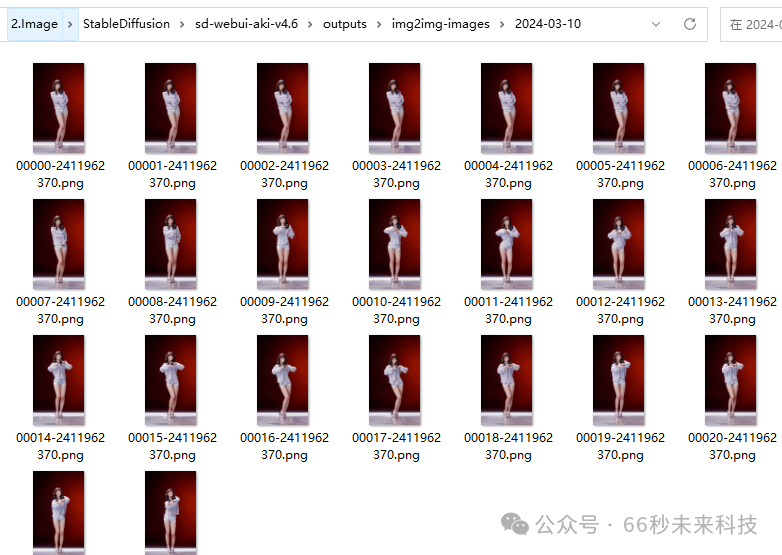

然后我们点击“文件夹”图标,来到sd默认的img2img-images文件夹。

在弹出的目录里,选择今天日期的文件夹,将里面的图片清空。

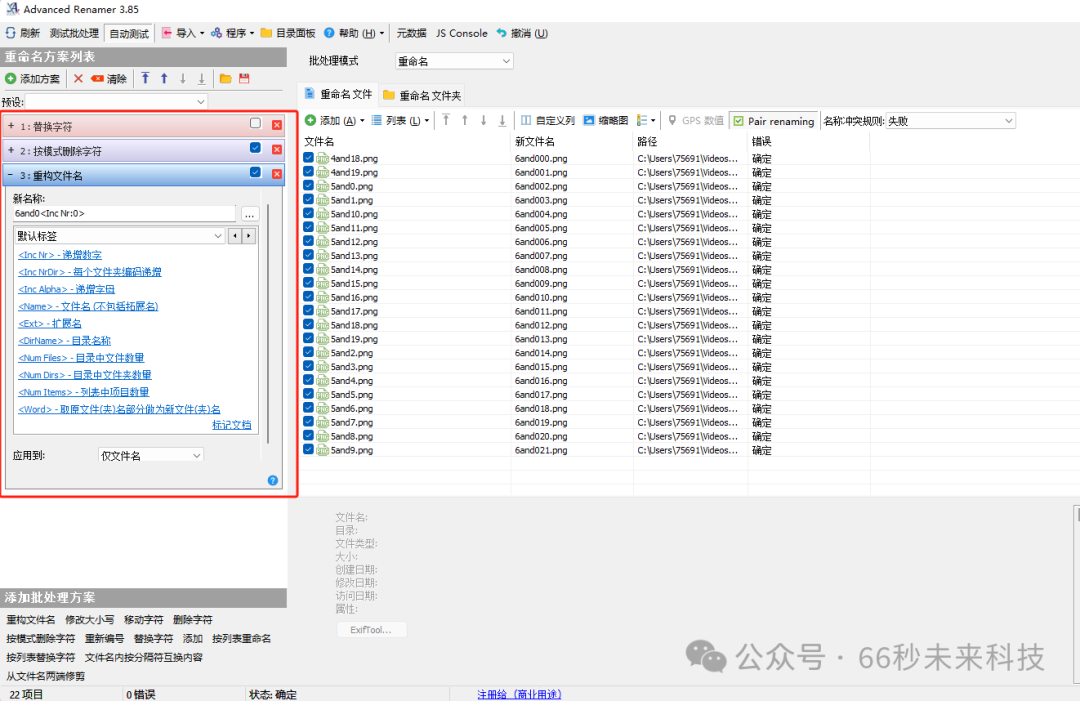

回到SD,后面就会正常输出在这个默认的目录下了。将这些图片复制到之前的output目录中,但是这些图片是无法构建key的,因为input下的图片命名要和output下的图片命名一致。

所以我们需要使用批量修改命名工具去处理output下的图片命名。

左边是修改策略,右边是图片文件和预览修改后的样子。工具文末获取。

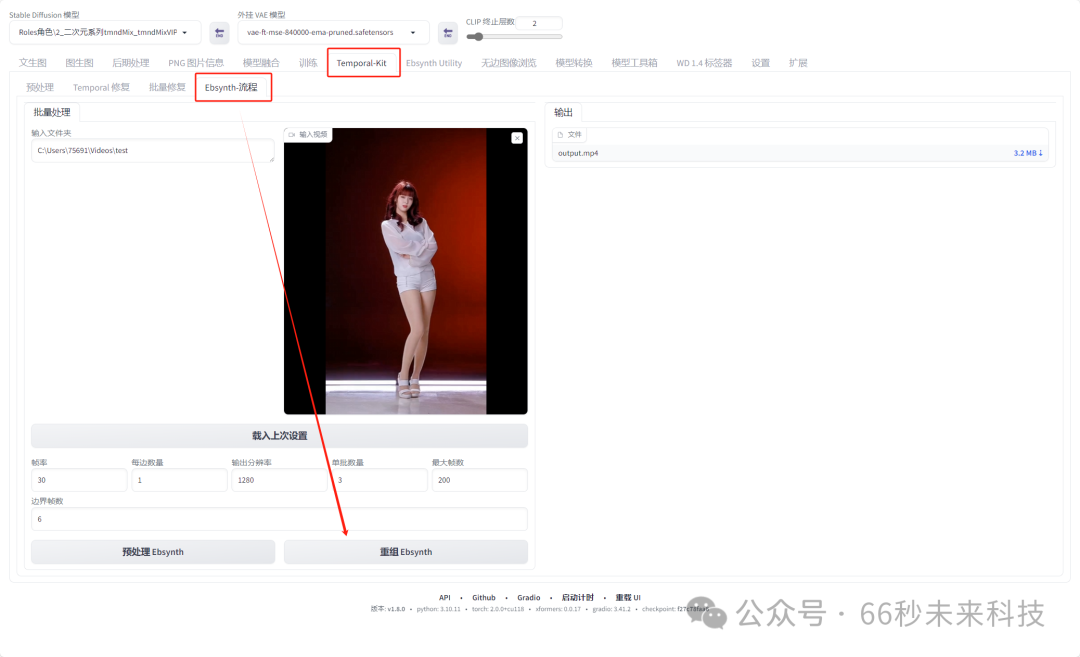

统一资源命名后,我们来到“Temporal-kit” 页签将视频和路径都填入设置。

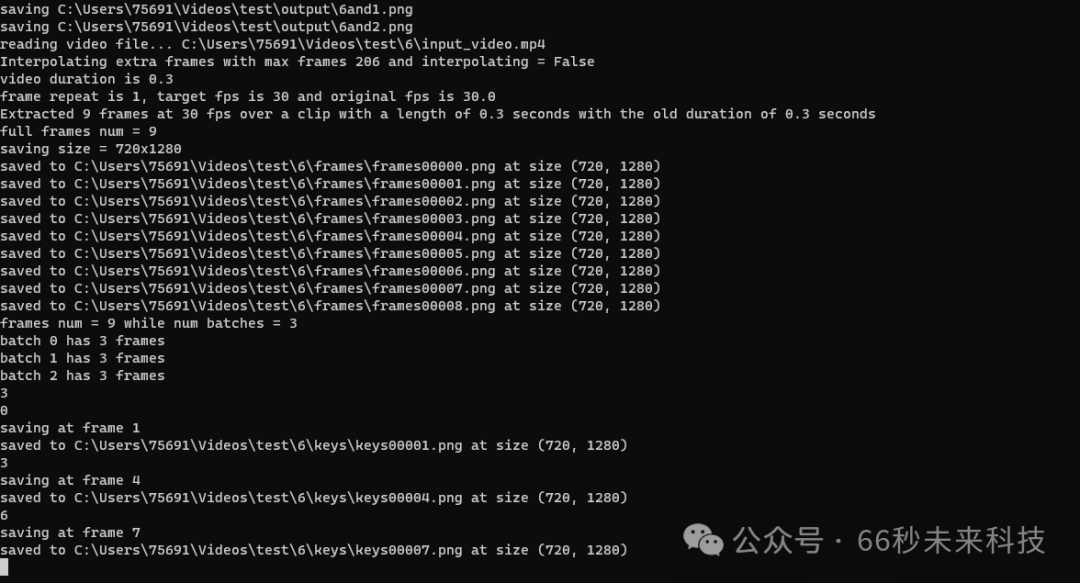

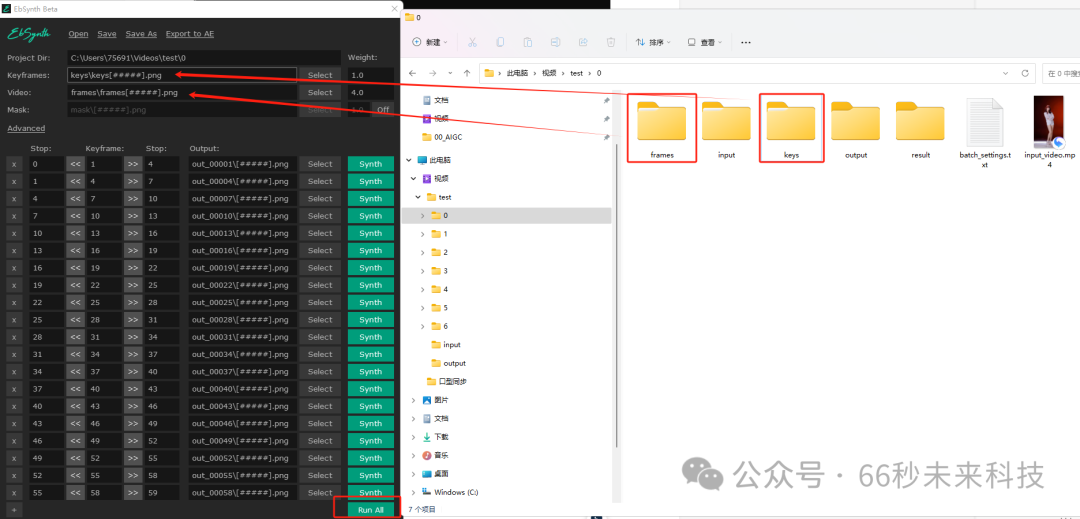

填写完成后,点击“预处理 Ebsynth” 让其为我们的0-6文件跑“frames”和“keys”

后台完成后,我们即将进入自动生成补间帧环节。

7. 生成补间帧:

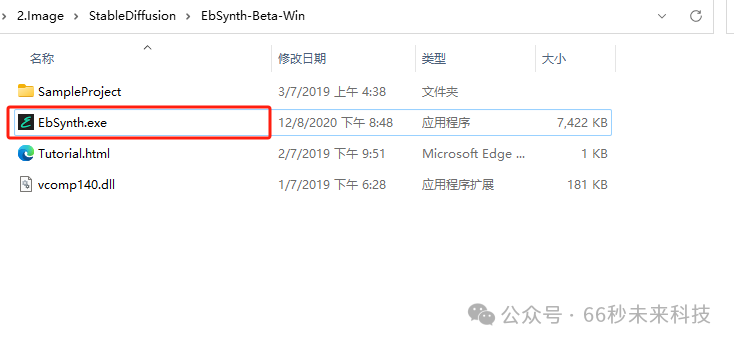

解压EbSynth-Beta-Win.zip压缩包到任意位置,这是一个exe执行程序,处理我们之前生成的0-6文件夹内的关键帧。资源可以在文末获取。

双击运行“EbSynth.exe”

将“frames”文件夹拖拽到,“Video:” 后面的路径里面。

将“keys”文件夹拖拽到,“Keyframes:” 后面的路径里面。

然后运行“EbSynth” 面板最下面的“Run AII” ,程序会开始自动生成补帧。

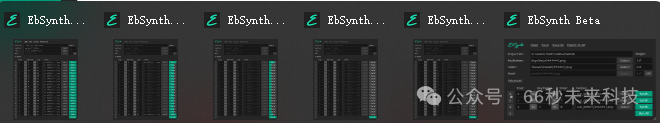

我们可以多开几个同时对0-6的文件夹处理,

注意每次使用,最好关掉重开!因为它不会自动更新最上级的路径。

完成后,我们将6个文件全部用上面一样的操作,执行一边。

8. 生成视频:

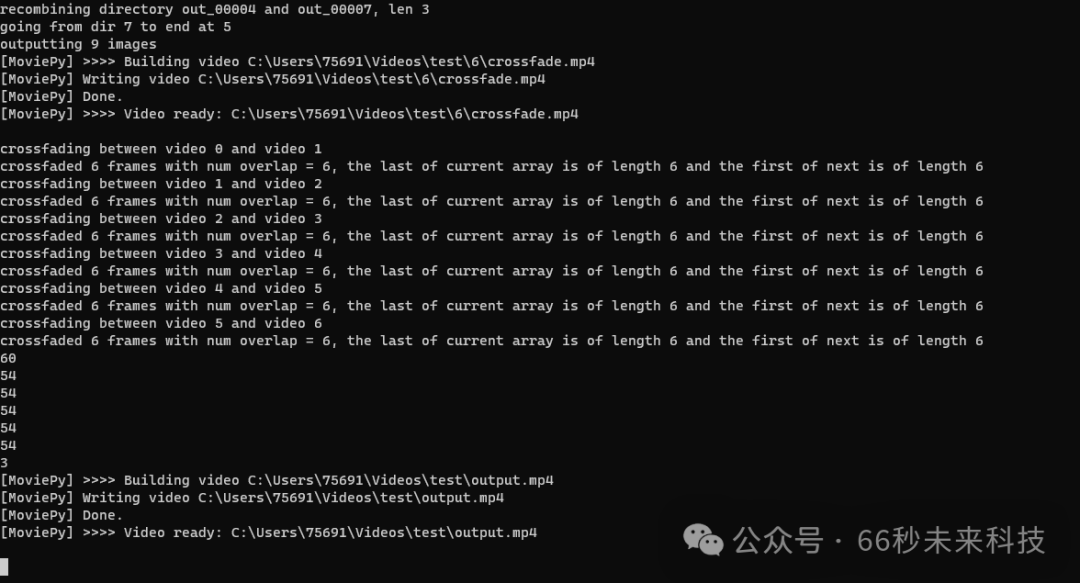

最后,我们再次回到“Temporal-Kit” 页签下“Ebsynth-流程” 页签,点击“重组 Ebsynth”来生成视频。

OK啦生成完成,流程部分到这里就结束了。但我一想其实还可结合之前的工具对视频进行放大处理。SD也有放大功能但是要重新渲染,下面的方式更简单。

工具获取看下方扫描获取

总结:

在本文中,我们详细探讨了使用SD-WebUI进行AI视频重绘的整个过程。这一过程涉及多个步骤,包括安装必要的软件和插件、分割视频、确定风格、批量渲染以及最终的视频生成。虽然这一流程相对复杂,需要一定的技术知识和耐心,但它提供了高度的自定义能力和本地化处理的优势,使得用户可以根据自己的需求和偏好来生成独特的视频内容。

总的来说,尽管SD-WebUI的视频重绘流程存在一定的门槛,但它提供了一个强大的平台,让用户能够创造出个性化的视频内容。通过本文的指导,即使是初学者也能够逐步掌握这一技术,享受到AI视频重绘带来的乐趣和创造力。

写在最后

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

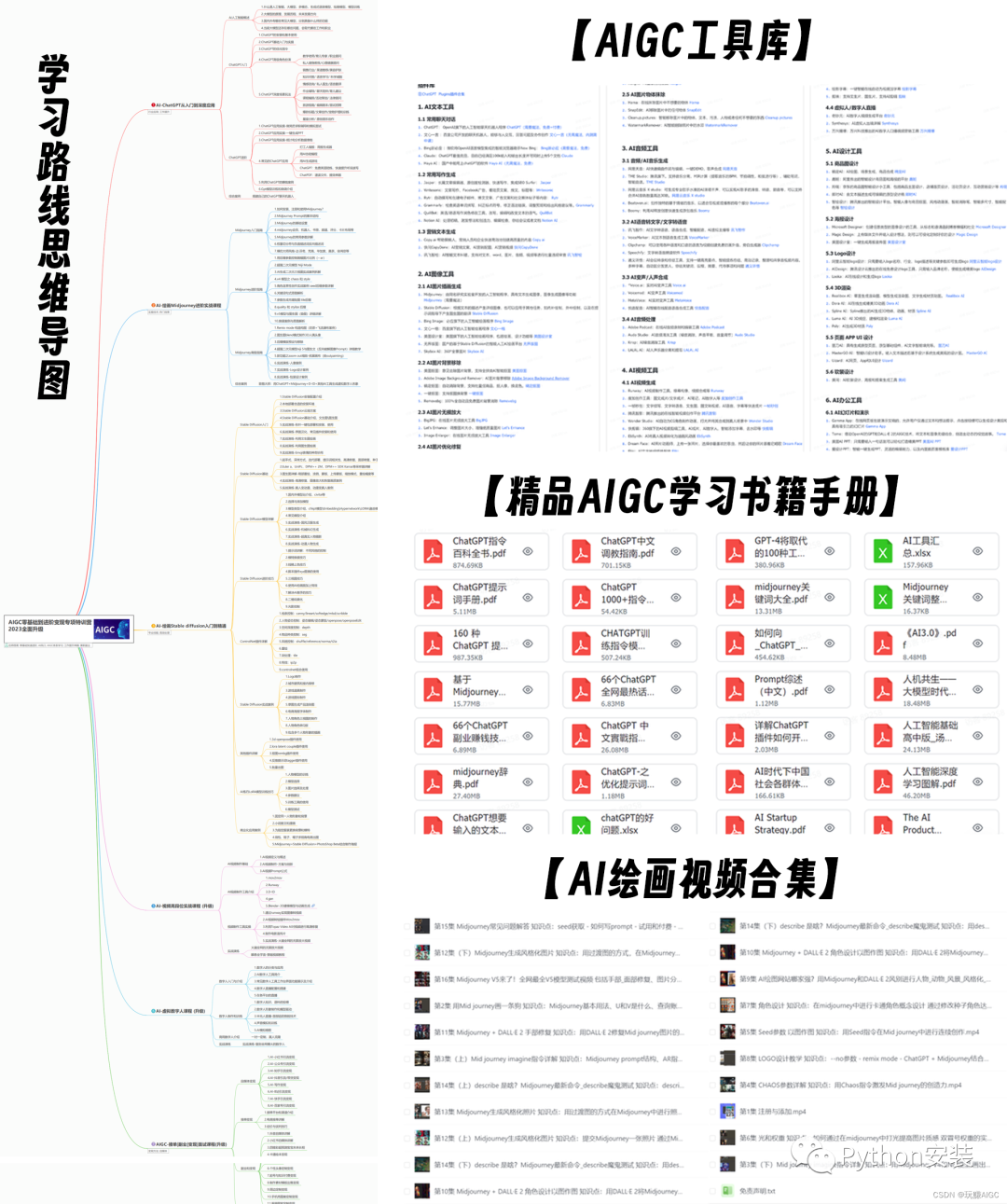

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

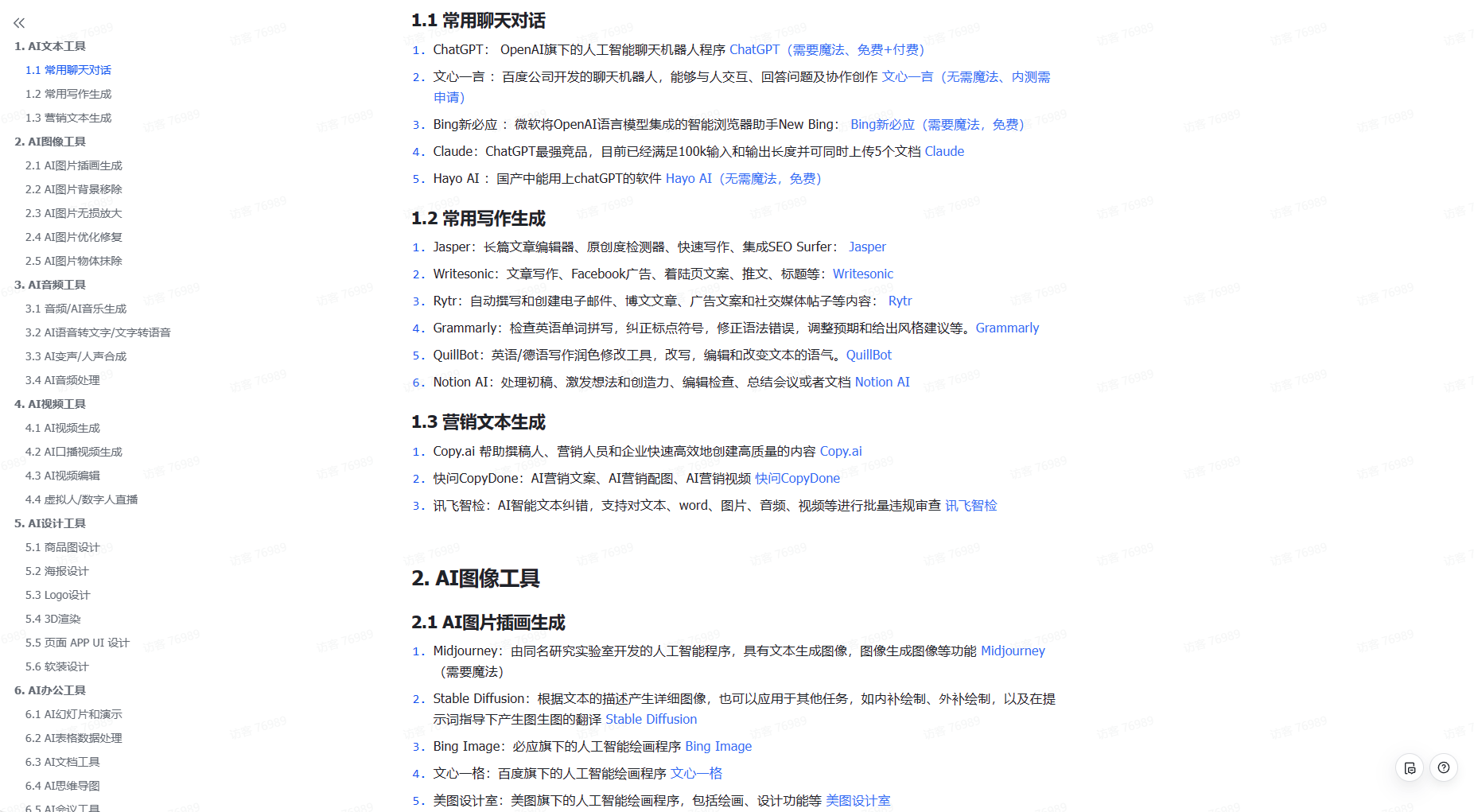

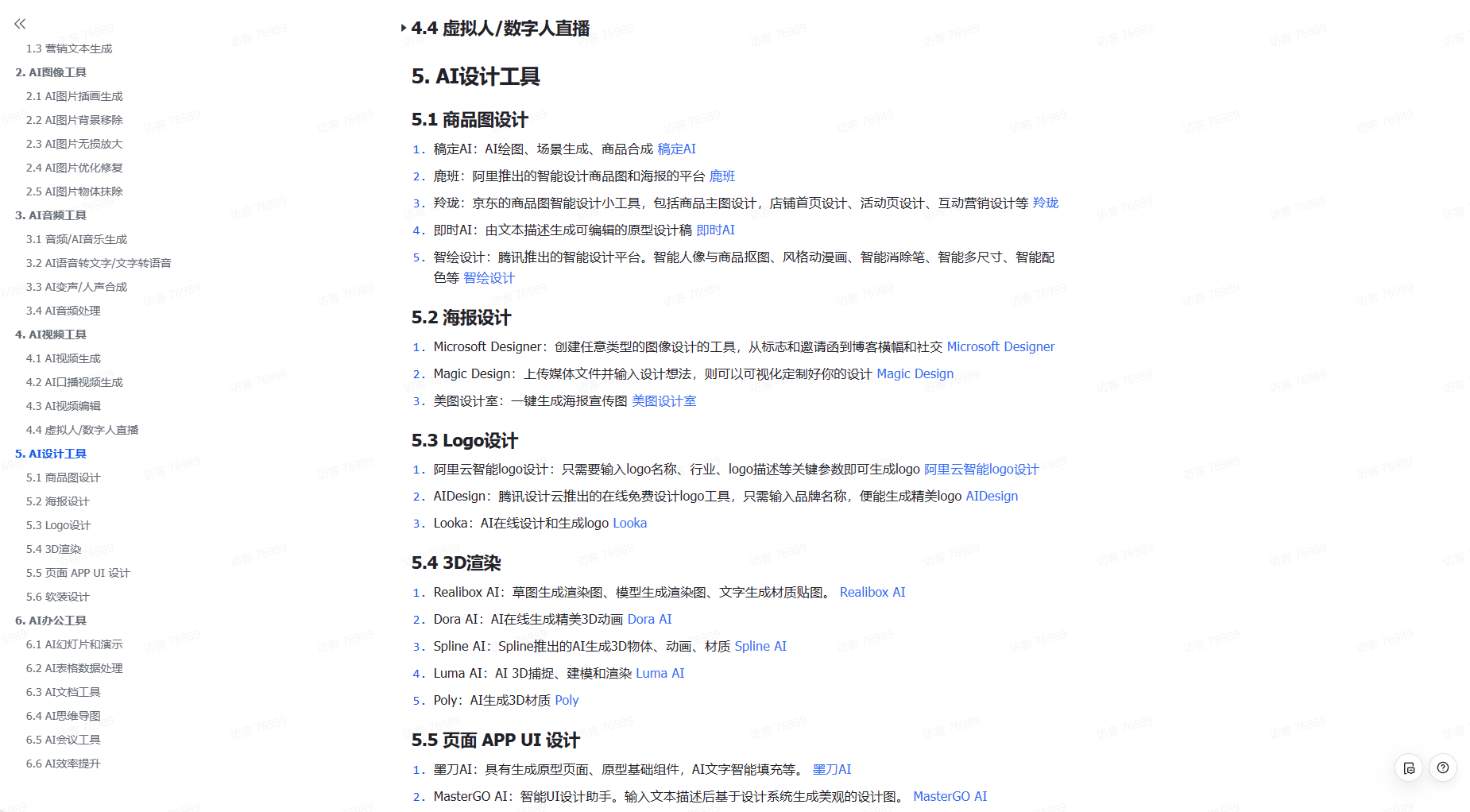

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

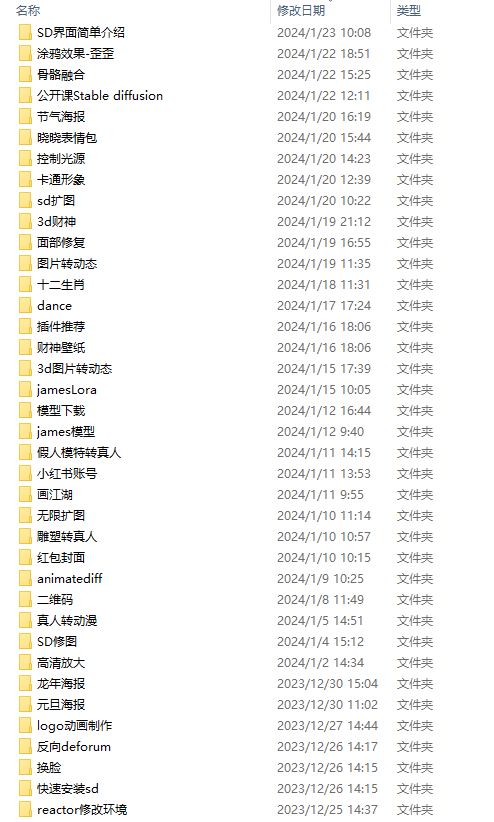

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

若有侵权,请联系删除