论文标题:TimeMachine: A Time Series is Worth 4 Mambas for Long-term Forecasting

(这篇的标题应该是在模仿PatchTST的标题:A time series is worth 64 words: Long-term forecasting with transformers)

作者: Md Atik Ahamed, Qiang Cheng

机构:肯塔基大学(UKY)

论文链接:https://arxiv.org/abs/2403.09898

Cool Paper:https://papers.cool/arxiv/2403.09898

代码:https://github.com/Atik-Ahamed/TimeMachine

TL;DR:本文提出了一个名为TimeMachine的模型,通过4个Mamba状态空间模型来有效地进行多变量时间序列的长期预测,同时保持线性可扩展性和低内存消耗。

关键词:长期时间序列预测(LTSF),选择性状态空间模型(SSSM),通道混合(Channel Mixing)、通道独立(Channel Independence

🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀

欢迎大家关注时空探索之旅

摘要

由于捕获长期依赖性、实现线性可扩展性和保持计算效率的困难,长期时间序列预测仍然具有挑战性。 推出了 TimeMachine,这是一个创新模型,它利用 Mamba(一种状态空间模型)来捕获多元时间序列数据中的长期依赖性,同时保持线性可扩展性和较小的内存占用。 TimeMachine 利用时间序列数据的独特属性来产生多尺度的显着上下文线索,并利用创新的集成 quadruple-Mamba 架构来统一对通道混合(channel-mixing)和通道独立(channel-independence)情况的处理,从而能够有效地选择内容进行预测 不同尺度的全局和局部上下文。 在实验上,TimeMachine 在预测准确性、可扩展性和内存效率方面实现了卓越的性能,并使用基准数据集进行了广泛验证。

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了一个名为TimeMachine的创新模型,旨在解决长期时间序列预测(Long-term Time-Series Forecasting, LTSF)的挑战。LTSF在多个领域如天气预报、异常检测、能源、农业、工业和国防资源规划等任务中至关重要。尽管已经开发了许多LTSF方法,但它们通常只能实现以下一个或两个期望属性:

捕获多变量时间序列(Multivariate Time Series, MTS)中的长期依赖关系。随着数据量的增加,模型参数的数量呈线性可扩展性。计算效率或在边缘计算中的适用性。论文指出,同时实现这些理想属性仍然是一个挑战。特别是,捕获长期依赖关系对于LTSF至关重要,但现有的线性模型(如DLinearer和TiDE)虽然具有竞争力的性能和线性复杂度,但它们依赖于多层感知器(MLPs)和线性投影,可能无法很好地捕获长期相关性。而基于Transformer的模型(如iTransformer、PatchTST和Crossformer)虽然能够通过自注意力机制捕获长期依赖关系并提高LTSF的准确性,但它们通常受到二次复杂度的限制,限制了它们的可扩展性和适用性。

为了解决这些问题,TimeMachine模型利用Mamba,一种状态空间模型(State-Space Model, SSM),来捕获多变量时间序列数据中的长期依赖关系,同时保持线性可扩展性和小内存占用。该模型通过创新的四重Mamba架构来统一处理通道混合和通道独立情况,有效选择不同尺度的全局和局部上下文内容进行预测。实验结果表明,TimeMachine在预测准确性、可扩展性和内存效率方面均取得了优越的性能。

Q: 有哪些相关研究?

A: 这篇论文提到了多个与长期时间序列预测(LTSF)相关的研究领域和具体方法,可以归纳为以下几类:

非Transformer基础的监督学习方法: 经典时间序列方法,如ARIMA、VARMAX、GARCH和RNN。基于深度学习的MLP和CNN方法,例如DLinear、TiDE和RLinear,使用多层感知器(MLPs)和卷积神经网络(CNNs)来实现。 基于Transformer的监督学习方法: iTransformer、PatchTST、Crossformer、FEDformer、stationary和autoformer等,这些方法将时间序列转换为标记序列,并利用自注意力机制来发现任意时间步骤之间的依赖关系。 自监督表示学习模型: 使用非Transformer基础模型(例如TS-TCC)和基于Transformer的模型(例如时间序列Transformer和TS-TCC)来学习时间序列的有用表示,用于下游任务。论文还提到了一些具体的模型和方法,包括但不限于:

Autoformer:一种结合自注意力和分解Transformer的模型,用于长期序列预测。Informer:一种高效的Transformer模型,用于处理长时间序列数据。Scinet:一种利用样本卷积和交互来进行时间序列建模和预测的方法。TimesNet:一种用于一般时间序列分析的Temporal 2D-Variation建模方法。此外,论文还提到了Mamba模型,这是一种具有选择性扫描能力的状态空间模型(SSM),TimeMachine模型正是基于Mamba构建的。Mamba模型能够捕获长期依赖关系,并且具有线性时间复杂度,使其成为处理长期时间序列预测的有力工具。

Q: 论文如何解决这个问题?

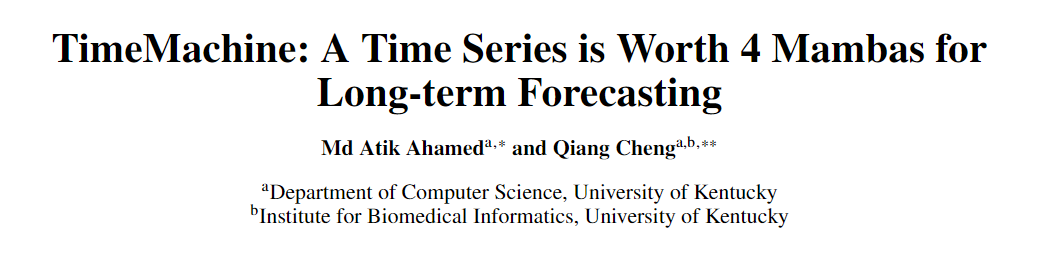

A: 论文通过提出一个名为TimeMachine的创新模型来解决长期时间序列预测(LTSF)的问题。TimeMachine模型的核心特点和解决策略如下:

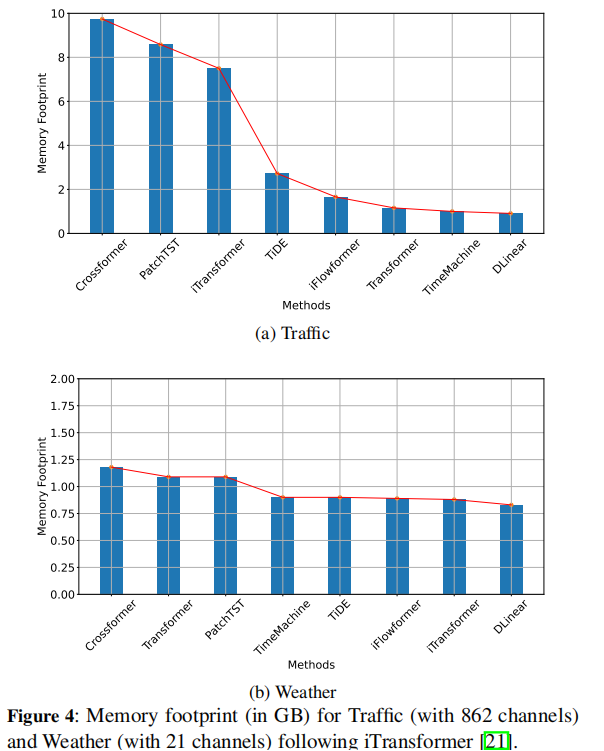

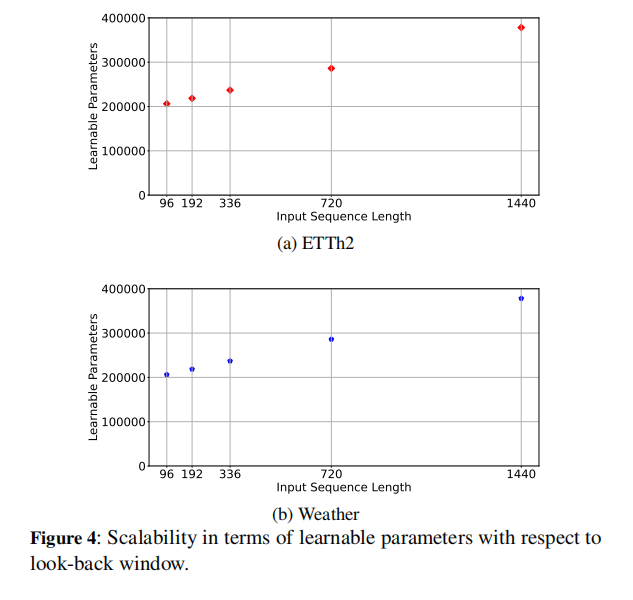

利用Mamba模型:TimeMachine模型使用Mamba,一种状态空间模型(SSM),来捕获多变量时间序列(MTS)数据中的长期依赖关系。Mamba模型具有线性时间复杂度,能够有效地处理长序列数据。多尺度上下文线索:TimeMachine通过连续分辨率降低或下采样生成两个尺度的上下文线索。第一层在高分辨率下工作,而第二层在低分辨率下工作。在每个尺度上,模型使用两个Mamba模块来从全局视角捕获通道混合情况下的上下文线索,以及从全局和局部视角捕获通道独立情况下的上下文线索。集成四重Mamba架构:TimeMachine采用一个创新的架构,将四个Mamba模块集成在一起,以统一处理通道混合和通道独立的情况。这种设计使得模型能够根据MTS数据的特点灵活地采用两种处理方式。输出投影:模型通过两个多层感知器(MLPs)P1和P2将Mamba模块的输出标记投影到所需的序列长度上,以生成最终预测。实验验证:TimeMachine在多个标准基准数据集上进行了广泛的实验验证,包括Weather、Traffic、Electricity和ETT数据集。实验结果表明,TimeMachine在预测准确性、可扩展性和内存效率方面均优于或可与当前最先进的方法相媲美。内存占用和可扩展性:TimeMachine模型展示了较小的内存占用,并且能够随着输入序列长度的增加而线性地增加可学习的参数数量,这表明了其在处理更长序列时的可扩展性。通过这些策略,TimeMachine模型能够有效地解决LTSF中的挑战,同时保持了计算效率和内存效率。

Q: 论文做了哪些实验?

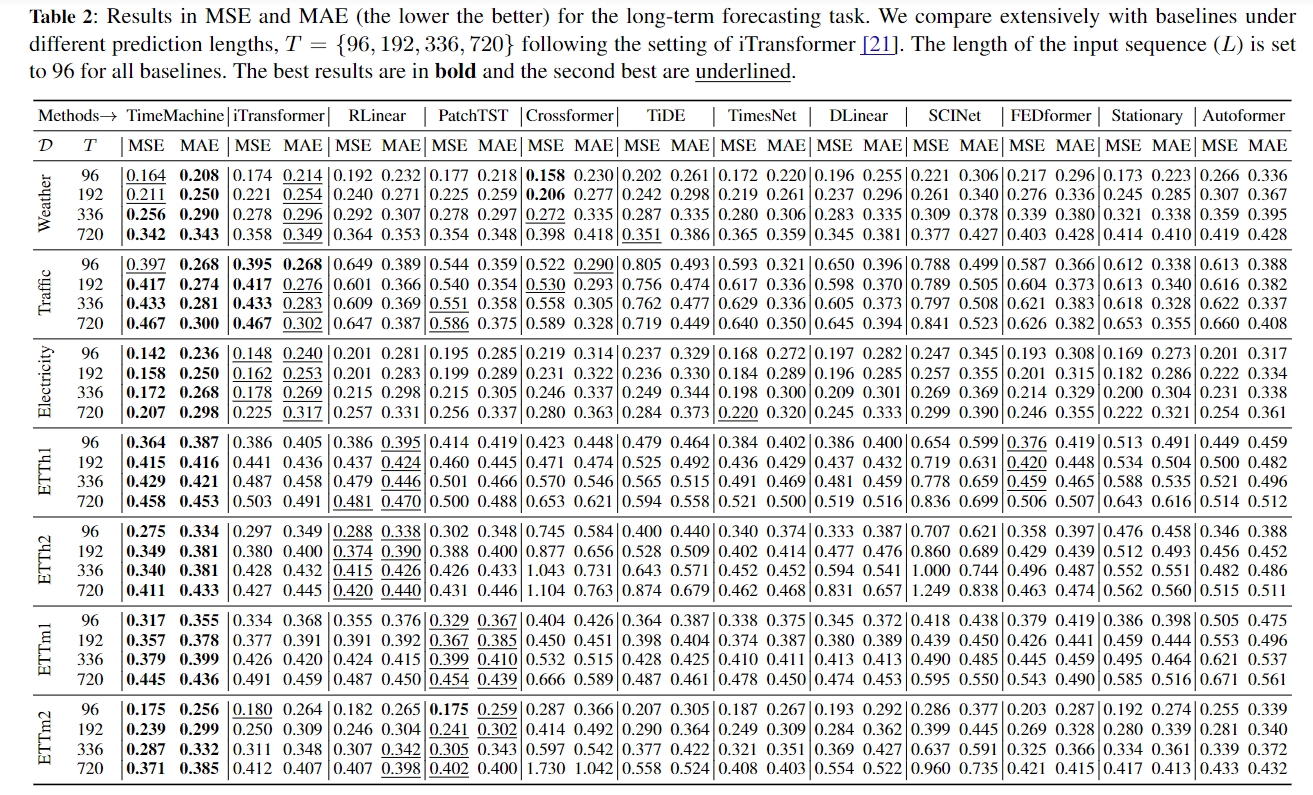

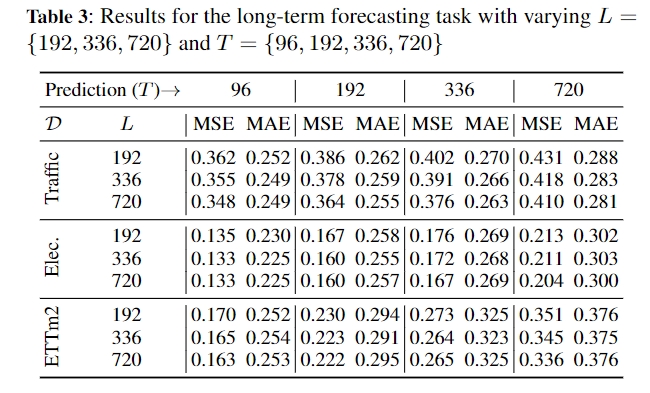

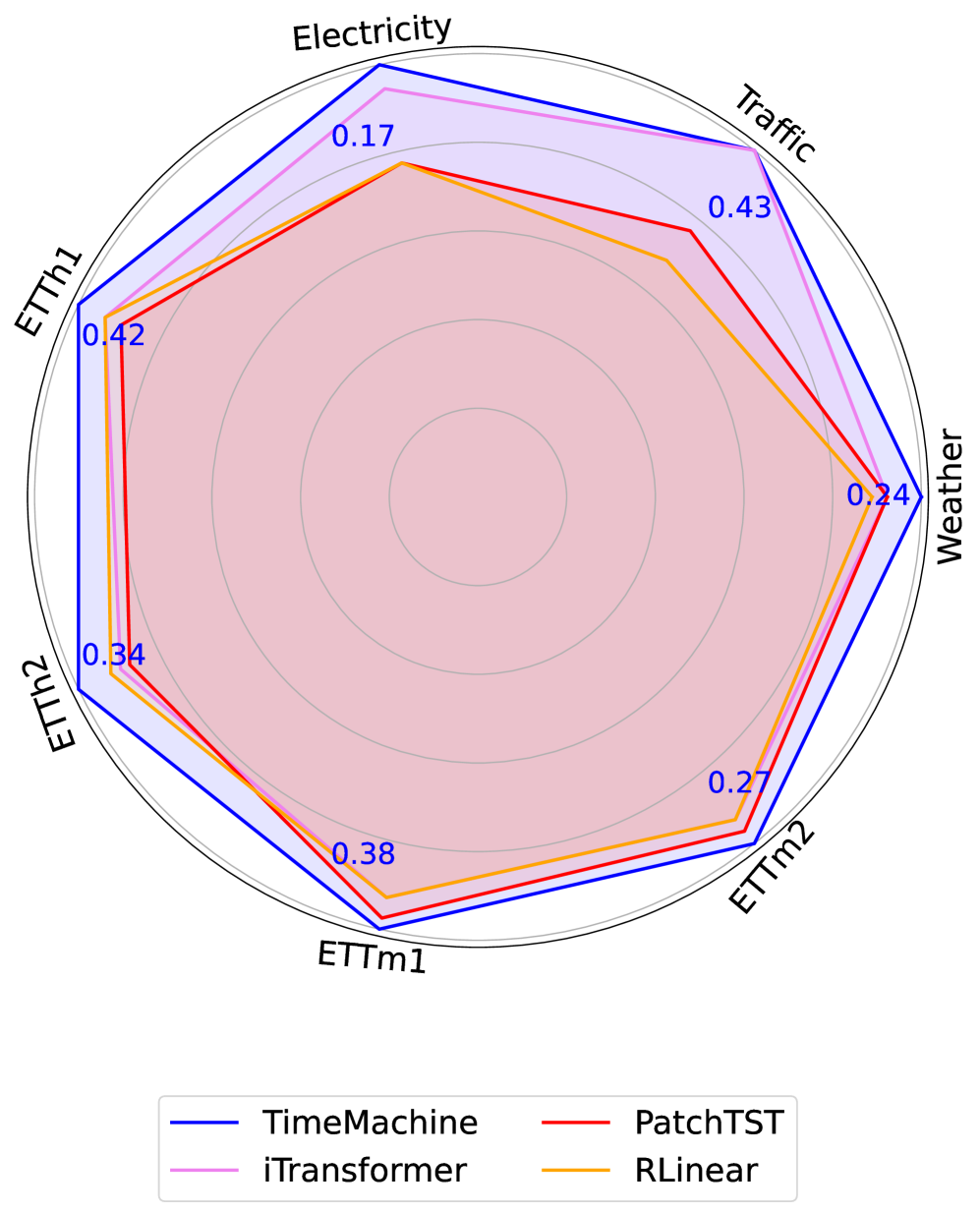

A: 论文中进行了一系列实验来验证TimeMachine模型在长期时间序列预测(LTSF)任务中的性能。以下是实验的主要组成部分:

基准数据集:作者在多个广泛认可的基准数据集上评估了TimeMachine模型,这些数据集包括Weather、Traffic、Electricity以及四个ETT(Electricity Transformer Temperature)数据集(ETTh1, ETTh2, ETTm1, ETTm2)。这些数据集涵盖了不同的领域和时间点数量,以测试模型在不同条件下的表现。性能比较:TimeMachine与其他11个最先进的模型进行了比较,包括iTransformer、PatchTST、DLinear、RLinear、Autoformer、Crossformer、TiDE、Scinet、TimesNet、FEDformer和Stationary。性能指标包括均方误差(MSE)和平均绝对误差(MAE),这些指标用于衡量预测准确性。不同预测长度:作者在不同的预测长度(T = {96, 192, 336, 720})下测试了TimeMachine模型,并设置了不同的输入序列长度(L = 96),以评估模型在不同预测范围的表现。扩展性测试:通过改变输入序列长度(L = {192, 336, 720}),作者评估了TimeMachine模型处理更长序列的能力,以及模型在不同长度下的可扩展性。内存占用和可扩展性:作者测量了TimeMachine模型和其他基线模型的GPU内存使用情况,以比较它们的内存效率。此外,还展示了模型在不同输入序列长度下的可学习参数数量,以证明其线性可扩展性。消融研究:为了展示模型中各个组件的有效性,作者进行了消融研究,包括对MLP参数(n1, n2)、dropout率、残差连接、Mamba的局部卷积宽度、状态扩展因子(N)和维度扩展因子(E)的敏感性分析。定性结果:作者提供了TimeMachine模型与第二名表现最好的方法之间的定性比较,通过可视化预测结果来展示模型在实际时间序列数据上的表现。这些实验结果表明TimeMachine在预测准确性、可扩展性和内存效率方面均取得了优越的性能,并且能够适应不同长度的时间序列数据和不同特性的多变量时间序列预测任务。

Q: 总结一下论文的主要内容

A: 这篇论文主要内容的总结如下:

问题陈述:长期时间序列预测(LTSF)是一个重要但具有挑战性的任务,尤其是在捕获长期依赖关系、实现线性可扩展性和保持计算效率方面。TimeMachine模型:为了解决这些挑战,论文提出了一个名为TimeMachine的新型模型,该模型基于Mamba状态空间模型(SSM),旨在捕获多变量时间序列数据中的长期依赖关系,同时保持线性可扩展性和小内存占用。方法论: 多尺度上下文:TimeMachine通过连续分辨率降低生成多尺度上下文线索,以捕获全局和局部的依赖关系。集成四重Mamba架构:模型结合了四个Mamba模块,以统一处理通道混合和通道独立的情况,有效选择不同尺度的上下文内容进行预测。输出投影:使用多层感知器(MLPs)将Mamba模块的输出标记投影到目标序列长度上,以生成最终预测。 实验验证: 在多个标准基准数据集上评估了TimeMachine的性能。与多个先进的基线模型进行了比较,包括Transformer和非Transformer模型。进行了消融研究,以验证模型组件的有效性。 结果:TimeMachine在预测准确性、可扩展性和内存效率方面均显示出优越的性能。未来工作:论文提出了未来可能的研究方向,包括自监督学习、多任务学习、模型解释性、实时预测、长期依赖关系的深入分析等。代码可用性:论文提供了TimeMachine模型的代码实现,可供研究社区进一步探索和验证。的性能。

6. 未来工作:论文提出了未来可能的研究方向,包括自监督学习、多任务学习、模型解释性、实时预测、长期依赖关系的深入分析等。

7. 代码可用性:论文提供了TimeMachine模型的代码实现,可供研究社区进一步探索和验证。

总体而言,这篇论文介绍了一个创新的时间序列预测模型,通过结合先进的架构和技术,有效地解决了LTSF中的一些关键问题,并在多个数据集上展示了其有效性。

🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀

欢迎大家关注时空探索之旅