本文目标

像 perplexity.ai 和秘塔,都是AI搜索,根据我们的输入内容,搜索网络资料,然后读取、分析、提炼、总结,给出结果。

LLocalSearch 是一个开源项目,可以在我们的本机实现 AI 搜索。

它使用的是本地运行的大模型,所以不需要 OpenAI 或 Google 等平台的 API KEY。

LLocalSearch 使用 ollama 管理大模型,使用 docker-compose 管理自身应用。

下面,我们的目标就是把 LLocalSearch 运行起来。

运行效果

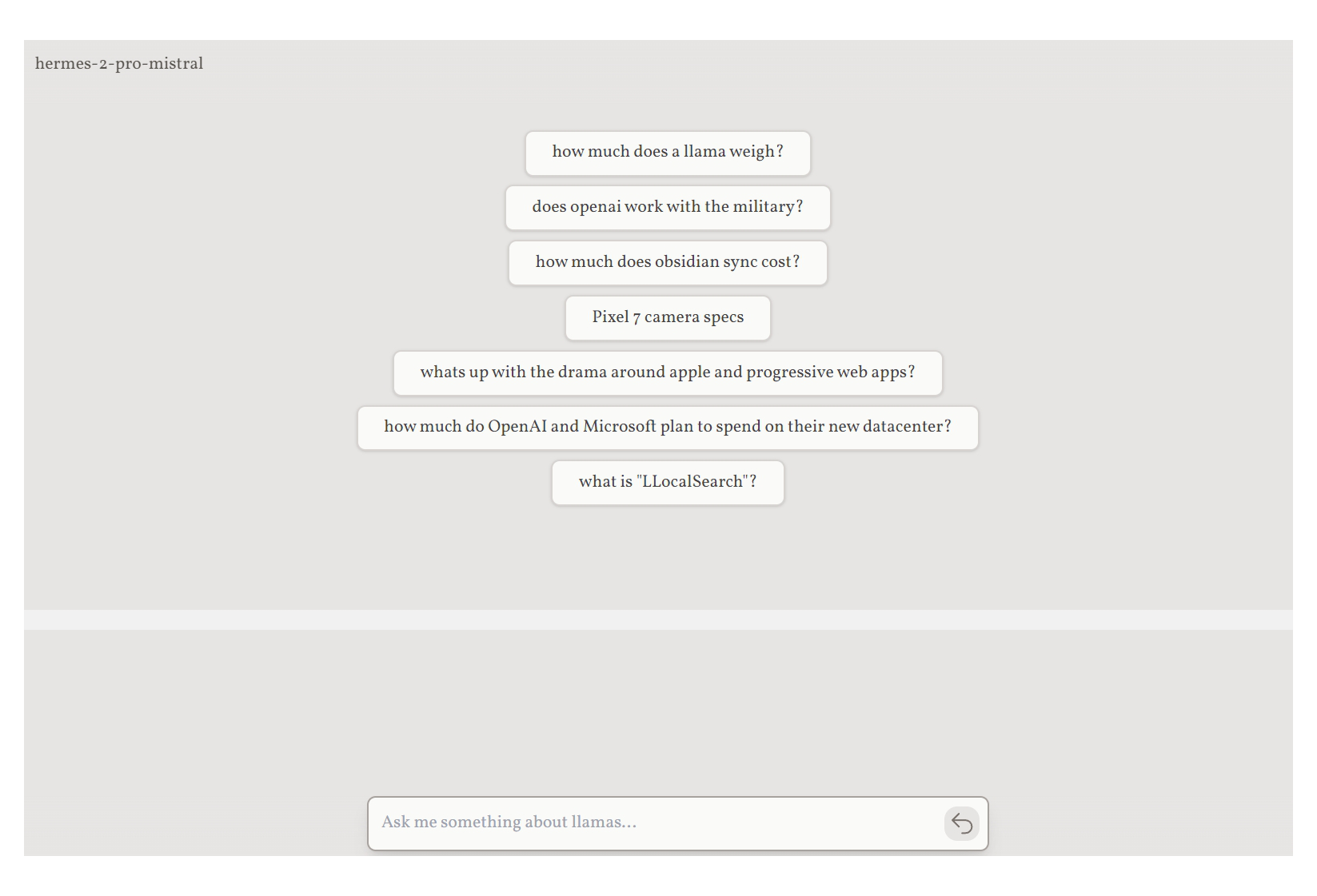

这是运行后的初始状态。

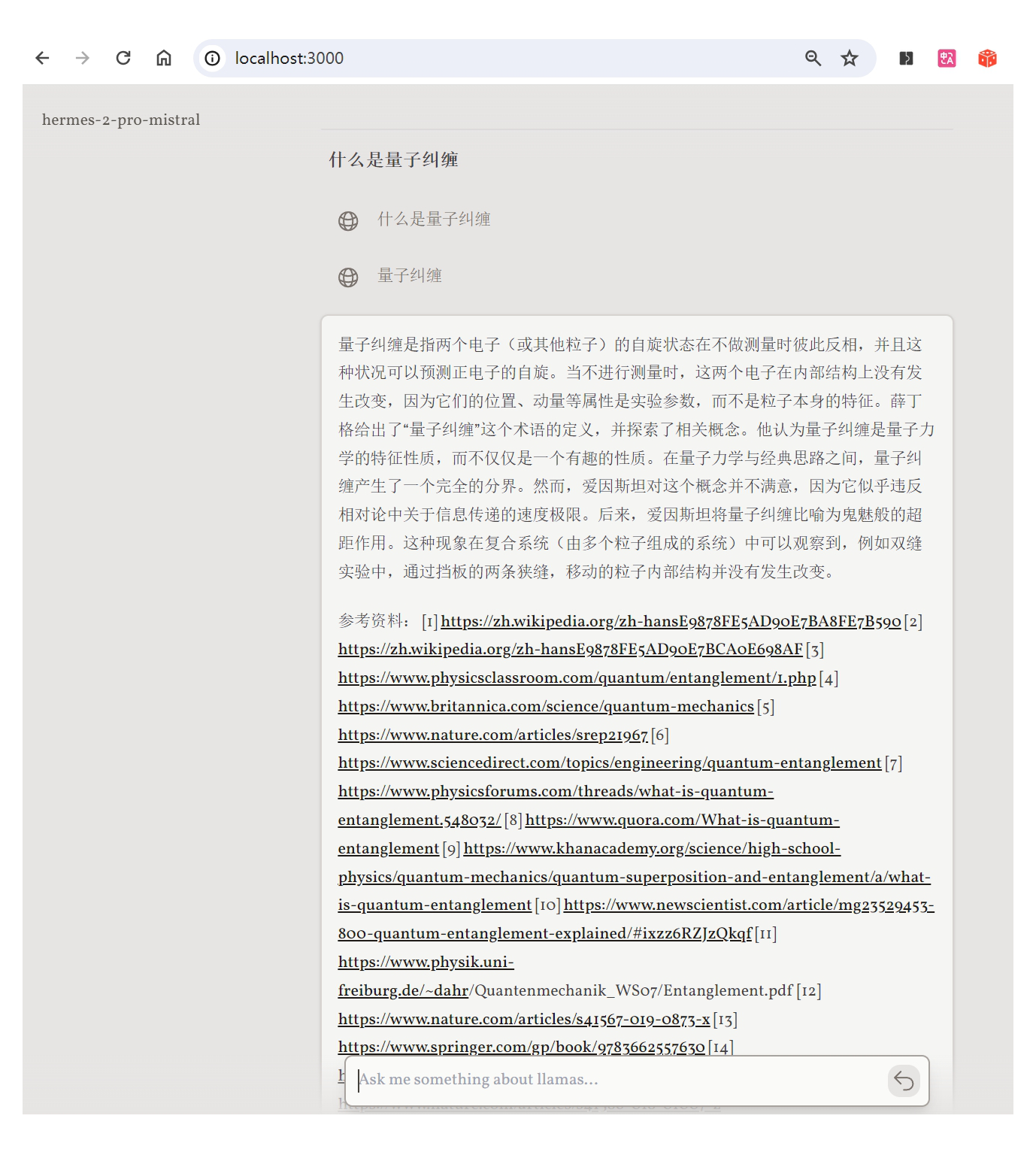

提了个问题 “什么是量子纠缠”。

LLocalSearch 经过搜索分析汇总,给出了结果。

并给出了它所读取的参考资料列表。

部署运行

Docker 和 Ollama 的安装非常简单,这里不在赘述。

1)配置和运行 Ollama

配置系统变量:

// Windows 使用 set,Linux 使用 exportset OLLAMA_HOST=0.0.0.0:11434这是为了让容器中运行的 LLocalSearch 可以访问到主机中的 Ollama 服务。

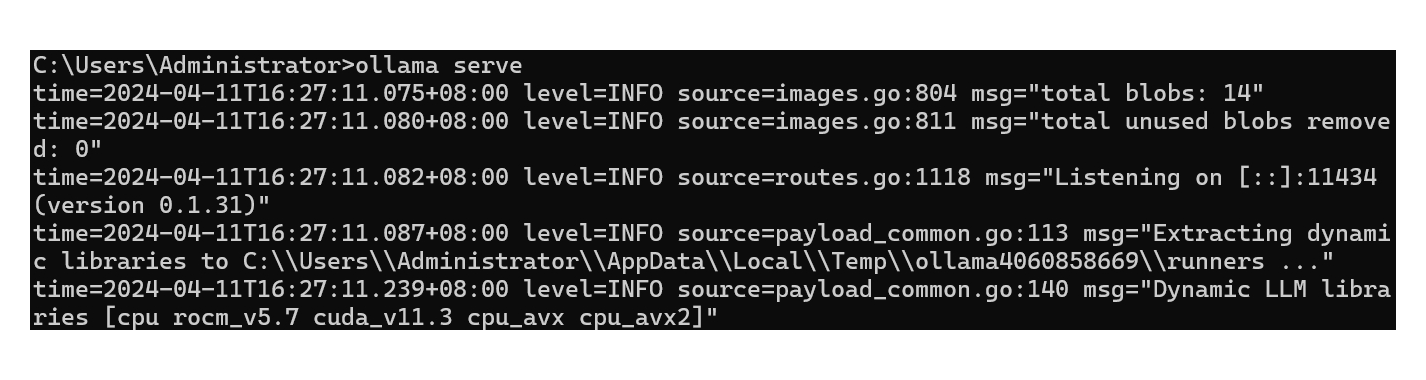

运行 Ollama:

ollama serve

2)配置 LLocalSearch

克隆项目

git clone https://github.com/nilsherzig/LLocalSearch.gitcd ./LLocalSearch复制目录中的环境配置文件 env-example 为 .env 然后修改其中的变量:

OLLAMA_HOST=http://[本机IP]:114343)启动 LLocalSearch

项目路径下执行:

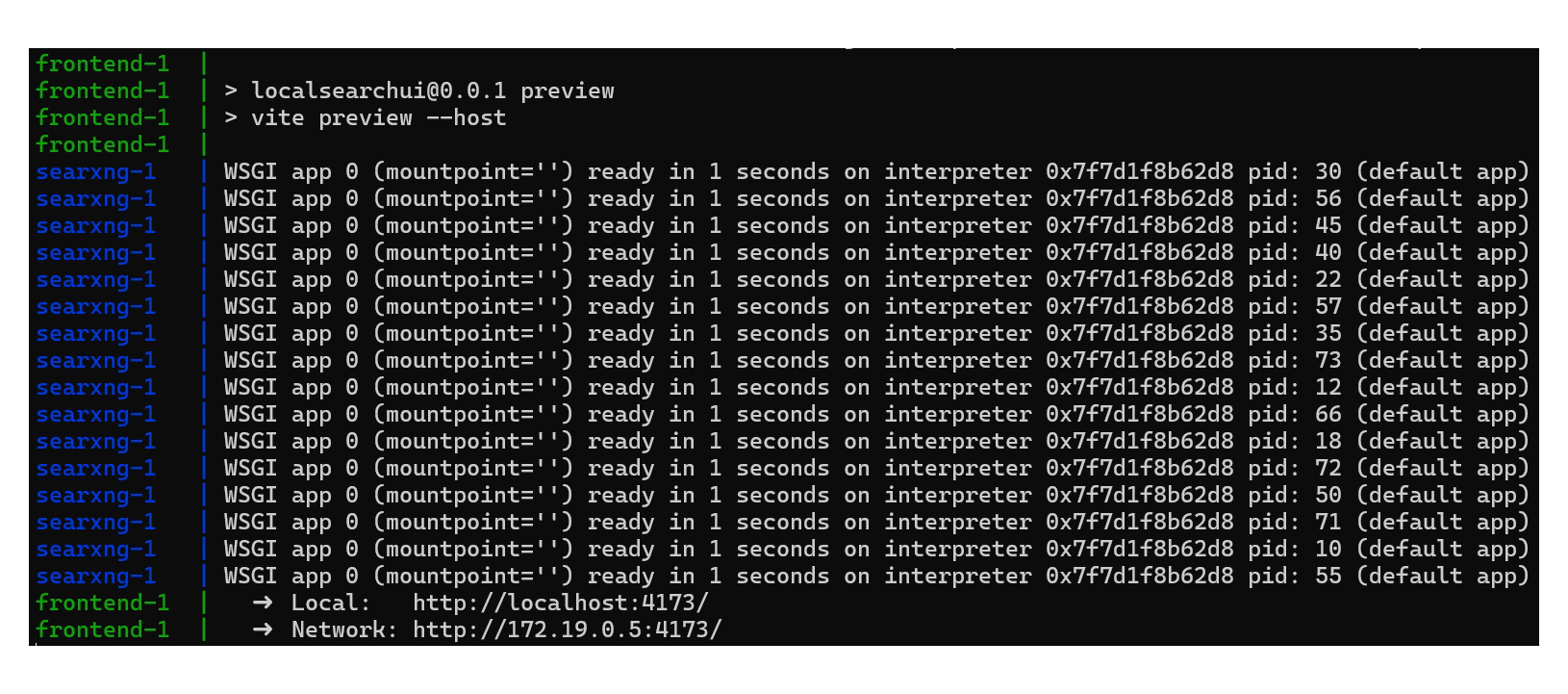

docker-compose up

启动结束后显示如上日志信息。

然后就可以访问了,浏览器打开:

http://localhost:3000/第一次提问后,LLocalSearch 会通过 Ollama 下载大模型,时间较长,需要耐心等待。

不错吧,赶快试试吧。

项目地址:

github.com/nilsherzig/LLocalSearch

#AI 人工智能,#AI搜索,#LLocalSearch,#perplexity.ai,#秘塔AI,#gpt890

信息来源 gpt890.com/article/45