文心一言

当谈到深度学习中的LSTM(Long Short-Term Memory)网络时,它是一种特殊的循环神经网络(RNN)架构,旨在解决传统RNN在处理长序列时遇到的梯度消失和梯度爆炸问题。LSTM网络因其能够捕捉序列数据中的长期依赖关系而在多个领域取得了显著的成果,特别是自然语言处理、语音识别、时间序列预测和图像描述生成等。

以下是关于LSTM网络的详细介绍:

基本结构

LSTM网络由多个LSTM单元(或称为LSTM细胞)组成,每个单元都包含四个主要部分:输入门、遗忘门、细胞状态和输出门。

输入门:控制新信息流入细胞状态的量。它根据当前输入和前一个隐藏状态来决定哪些信息应该被更新。遗忘门:决定从细胞状态中丢弃哪些信息。它根据当前输入和前一个隐藏状态来生成一个介于0和1之间的权重,用于控制细胞状态中的信息保留程度。细胞状态:是LSTM网络的核心,负责保存长期依赖信息。它通过遗忘门和输入门来更新自身的内容。输出门:控制从细胞状态到当前输出隐藏状态的信息量。它根据当前输入和前一个隐藏状态来决定哪些信息应该被传递给下一个LSTM单元或作为当前输出。工作原理

在LSTM网络中,信息通过时间步(time step)在LSTM单元之间传递。在每个时间步,LSTM单元都会根据当前输入和前一个隐藏状态来更新其内部状态,并产生一个输出。这个输出将作为下一个时间步的输入之一,与下一个时间步的原始输入一起传递给下一个LSTM单元。通过这种方式,LSTM网络可以捕捉序列数据中的长期依赖关系。

优点

长期依赖捕捉:LSTM网络通过其独特的门控机制,能够有效地捕捉序列数据中的长期依赖关系。避免梯度消失和梯度爆炸:由于LSTM网络中的门控机制和细胞状态,它能够在一定程度上避免传统RNN在处理长序列时遇到的梯度消失和梯度爆炸问题。灵活性强:LSTM网络可以根据具体任务的需求进行扩展和修改,例如通过增加多层LSTM单元或使用双向LSTM结构来提高模型的性能。应用场景

LSTM网络在自然语言处理、语音识别、时间序列预测等领域有着广泛的应用。例如,在机器翻译任务中,LSTM网络可以捕捉源语言句子中的语法和语义信息,并将其转换为目标语言句子中的相应表达;在股票价格预测任务中,LSTM网络可以捕捉历史价格数据中的趋势和模式,并据此预测未来的价格走势。

智谱清言

当然可以。

LSTM(Long Short-Term Memory,长短时记忆)网络是深度学习领域中的一种重要的循环神经网络(RNN)架构。由Hochreiter和Schmidhuber于1997年首次提出。LSTM网络特别适合处理和预测序列数据中的时间依赖性问题,例如自然语言处理、语音识别和时间序列预测等。

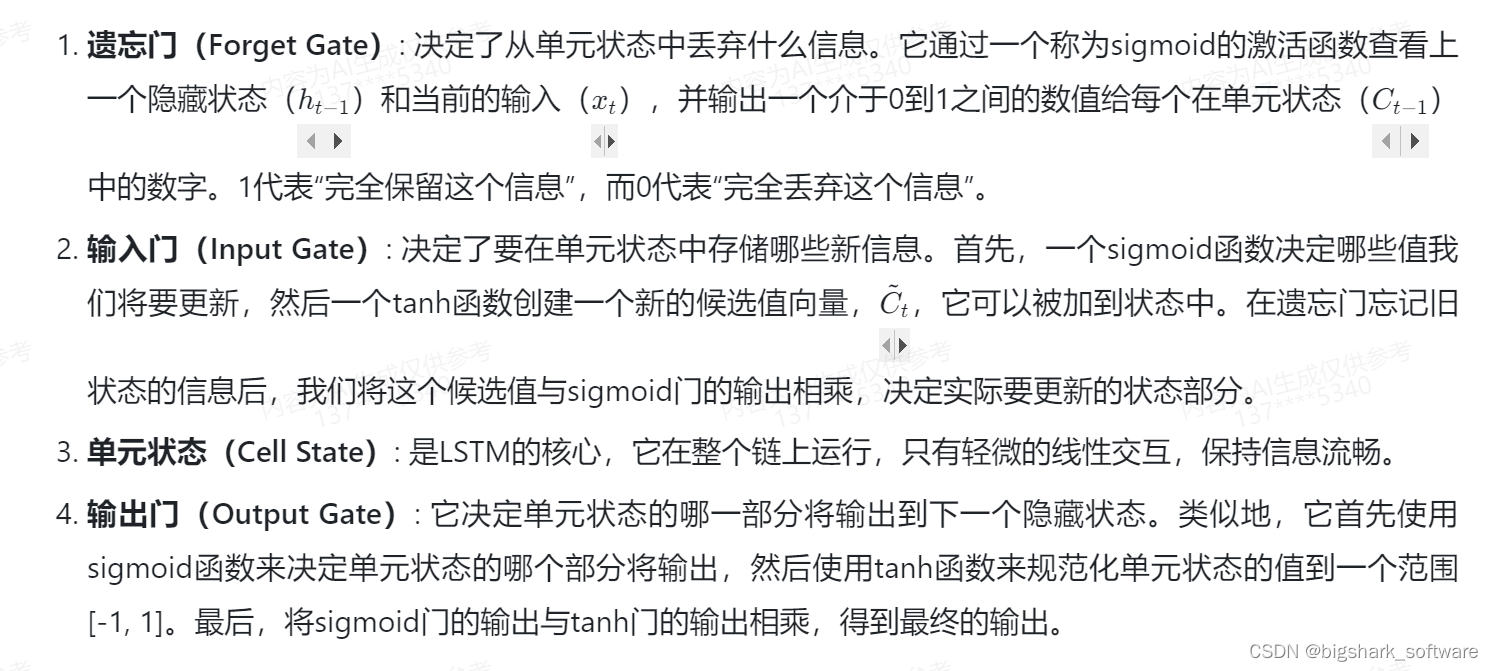

LSTM的核心思想是其所谓的“单元状态”(cell state),以及与其相互作用的三个门结构:遗忘门(forget gate)、输入门(input gate)和输出门(output gate)。

LSTM的这种设计允许它在长序列中保持和修改其内部状态,因此特别适合处理长距离的时间依赖性问题。相比于传统的RNN,LSTM能更好地避免梯度消失和梯度爆炸问题,这使得它在很多实际应用中表现卓越。

在过去的几十年里,LSTM及其变体已经在许多领域中取得了显著的成果,包括机器翻译、语音识别、文本摘要、视频分析等。

豆包

LSTM(Long Short-Term Memory)是一种特殊的循环神经网络(RNN)变体,主要用于处理序列数据。

LSTM 能够有效地解决传统 RNN 中存在的长期依赖问题。它通过引入记忆单元和门控机制,包括输入门、遗忘门和输出门,来控制信息的流动和存储。

输入门决定哪些新信息进入记忆单元;遗忘门决定遗忘哪些过去的信息;输出门则控制输出的信息。

LSTM 在自然语言处理、语音识别、时间序列预测等领域有广泛的应用。

讯飞星火

LSTM网络,全称长短期记忆(Long Short Term Memory)网络,是一种特殊的循环神经网络(RNN),主要用于处理序列数据,并在语音识别、图片描述、自然语言处理等领域得到广泛应用。

LSTM的关键特点包括:

解决长期依赖问题:与传统的RNN相比,LSTM能够更有效地学习序列中的长期依赖关系,这得益于其独特的“门”结构和细胞状态设计,可以控制信息的流入和流出,避免梯度消失和梯度爆炸问题。门结构:LSTM引入了输入门、遗忘门和输出门,这些门可以精细地调节信息流。输入门负责决定哪些新信息会被存储,遗忘门则决定哪些旧信息需要被丢弃,输出门调节哪些状态会被用来产生输出。细胞状态:LSTM的核心是细胞状态,它在序列的整个过程中都保持运行,只有通过门结构的调节才会发生细微的改变。这使得网络可以在长序列中传递必要的信息,而不会像传统RNN那样迅速丧失对先前信息的记忆。应用广泛:由于其在处理时间序列数据方面的优越性,LSTM在很多涉及序列到序列的任务中表现出色,例如文本翻译、语音到文本转换等。复杂的结构:尽管效果显著,但LSTM的结构相对复杂,这也导致了它的变体GRU(门控循环单元)的出现。GRU简化了LSTM的部分结构,同时在某些任务上能达到与LSTM相当的性能。总的来说,LSTM网络因其在处理和学习长期依赖方面的强大能力而在深度学习领域占据重要地位。