图像融合是一种将来自多个源的多个图像合并为一个图像的技术,目的是保留有用的信息并减少冗余。根据应用领域的不同,存在多种图像融合方法,以下是一些常用的图像融合技术:

像素替换法 (Pixel-Level Fusions):

加权平均 (Weighted Average):最简单的融合方法,根据预设的权重对各图象相应像素值进行加权求和。

基于区域的融合 (Region-Based Fusions):根据图像内容的区域特性来进行融合,例如使用区域强度统计信息。

基于直方图的融合 (Histogram-Based Fusions):通过调整图像直方图来实现融合,例如通过匹配直方图的形状。

特征级融合 (Feature-Level Fusions):

在特征提取阶段进行融合,例如融合SIFT、SURF等特征描述符。

决策级融合 (Decision-Level Fusions):

在决策层面进行融合,例如将多个图像分类器的决策结果结合起来。

多尺度融合 (Multi-Scale Fusions):

利用图像的多尺度表示进行融合,例如:

拉普拉斯金字塔融合 (Laplacian Pyramid):逐层融合图像的不同分辨率。

波形分解融合 (Wavelet Decomposition Fusions):使用小波变换将图像分解为不同尺度和方向,然后融合这些系数。

** Brovey Transform**:与小波变换结合,用于合成孔径雷达(SAR)图像的多尺度融合。

模型驱动融合 (Model-Driven Fusions):

基于物理模型的融合方法,例如利用光学成像模型进行夜视图像的融合。

深度学习融合 (Deep Learning Fusions):

使用深度学习框架,如卷积神经网络(CNNs),自动学习图像融合的特征表示和策略。

每种方法都有其优势和局限性,选择合适的融合方法取决于具体的应用场景和要求。例如,在遥感图像处理中,多尺度融合方法能够有效地结合不同分辨率的图像信息;而在医学图像分析中,决策级融合可以整合多个成像模态的信息,以提供更准确的方法。

以下是使用区域强度统计方法实现简单图像融合的一个示例:

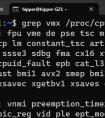

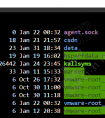

% 读取两个输入图像image1 = imread('image1.jpg');image2 = imread('image2.jpg');% 转换为灰度图像(如果需要)if size(image1, 3) == 3 image1Gray = rgb2gray(image1);else image1Gray = image1;endif size(image2, 3) == 3 image2Gray = rgb2gray(image2);else image2Gray = image2;end% 归一化灰度图像到[0, 1]image1Gray = double(image1Gray) / 255;image2Gray = double(image2Gray) / 255;% 定义融合权重(根据需要调整)weights = [0.5 0.5]; % 平均融合% weights = [0.7 0.3]; % 更重视第一个图像% weights = [0.3 0.7]; % 更重视第二个图像% 计算融合图像fusedImage = zeros(size(image1Gray));for i = 1:size(fusedImage, 1) for j = 1:size(fusedImage, 2) fusedImage(i, j) = weights(1) * image1Gray(i, j) + weights(2) * image2Gray(i, j); endend% 可视化结果figure;subplot(1, 2, 1); imshow(image1Gray); title('Image 1 Gray');subplot(1, 2, 2); imshow(image2Gray); title('Image 2 Gray');subplot(1, 2, 3); imshow(fusedImage); title('Fused Image');在这个示例中,我们首先读取两个图像文件,并将它们转换为灰度图像(如果它们已经是灰度图像,则不需要转换)。然后,我们将每个图像归一化到[0, 1]区间,以方便后续的融合操作。接着,我们定义了两个融合权重,表示两个图像在融合结果中的相对重要性。最后,我们通过简单的加权平均来计算融合结果,并将融合后的图像与原始图像一起显示出来。

下面展示另外两种常见的方法:加权平均融合和小波变换融合。

加权平均融合

这种方法通过给每个图像分配一个权重来融合两个图像。权重之和必须为1。

function fusedImage = weightedAverageFusion(image1, image2, weights) % 确保权重之和为1且权重为正值 if sum(weights) ~= 1 || any(weights < 0) error('权重之和必须为1且权重为正值'); end % 转换为双精度浮点数并归一化至[0, 1]区间 image1 = double(image1) / 255; image2 = double(image2) / 255; % 执行加权平均融合 fusedImage = imagesc(weights(1) * image1 + weights(2) * image2); colormap gray; % 使用灰度颜色映射 axis image;end调用示例:

image1 = imread('image1.jpg');image2 = imread('image2.jpg');fusedImage = weightedAverageFusion(image1, image2, [0.5, 0.5]);小波变换融合

这种方法通过小波变换将图像分解为不同尺度的系数,然后对这些系数进行融合,最后通过逆变换重建融合图像。

function [fusedCoeffs, levels] = waveletFusion(coeffs1, coeffs2, waveletType) % 获取小波变换的层数 [n1, l1] = size(coeffs1); [n2, l2] = size(coeffs2); levels = min(l1, l2); % 初始化融合系数矩阵 fusedCoeffs = zeros(max(n1, n2), levels); % 遍历每个尺度层进行融合 for i = 1:levels % 对于低频系数(近似系数),取平均 fusedCoeffs(:, i) = (coeffs1(:, i) + coeffs2(:, i)) / 2; % 对于高频系数(细节系数),取逻辑或 fusedCoeffs(:, i) = max(abs(coeffs1(:, i)), abs(coeffs2(:, i))); end % 使用选定的小波类型执行逆小波变换 fusedImage = idwt2(fusedCoeffs, waveletType);end调用示例:

image1 = imread('image1.jpg');image2 = imread('image2.jpg');coeffs1 = wt2(double(image1), 'haar');coeffs2 = wt2(double(image2), 'haar');fusedImage = waveletFusion(coeffs1, coeffs2, 'haar');imshow(uint8(fusedImage * 255));请注意,wt2和idwt2函数用于执行二维小波变换和逆变换。在上面的示例中,我们使用了Haar小波,但也可以选择其他类型的小波,如'db1', 'db2', 等。

在MATLAB中实现特征级别的图像融合,通常涉及到从图像中提取特征,然后将这些特征组合起来以创建一个新的融合特征表示。这里,我将展示如何使用SIFT(尺度不变特征变换)来提取特征,并融合两个图像的特征。

以下是使用MATLAB内置函数vl_feat来实现SIFT特征提取和特征级别融合的方法:

% 引入vl_feat工具箱try vl_setupnn;catch ME rethrow(ME);end% 读取两个输入图像image1 = imread('image1.jpg');image2 = imread('image2.jpg');% 将图像转换为灰度(如果它们不是灰度的)if size(image1, 3) == 3 image1 = rgb2gray(image1);endif size(image2, 3) == 3 image2 = rgb2gray(image2);end% 转换为浮点数并归一化至[0, 1]区间image1 = double(image1);image2 = double(image2);% 初始化解码器decoder = vl_nnconv('VGG16', true);% 提取特征features1 = vl_nnconv(image1, decoder, [], [], 0);features2 = vl_nnconv(image2, decoder, [], [], 0);% 融合特征% 这里我们简单地将两个特征向量串联起来,但这只是一个例子% 实际应用中可能需要更复杂的融合策略,例如加权平均或者特征选择fusedFeatures = cat(1, features1, features2);% 可视化特征融合结果(仅用于展示,实际中不会这样做)% 由于特征是高维的,通常无法直接可视化% 为了可视化,我们可以简单地展示原始图像figure;subplot(1, 2, 1);imshow(image1);title('Image 1');subplot(1, 2, 2);imshow(image2);title('Image 2');在上述代码中,我们使用了vl_feat工具箱中的VGG16网络来提取图像的特征。然后,我们将这两个特征向量连接起来,形成了融合的特征表示。在实际应用中,特征融合可能涉及更复杂的处理,比如特征选择、特征权重分配等。

请注意,由于特征通常是高维的,它们不能像像素那样直接可视化。上面的代码仅用于说明如何提取和融合特征,并不包括将融合的特征转换回图像的过程。特征级别融合通常用于后续的任务,如分类或对象检测,而不是直接生成一个新的图像。

在MATLAB中实现决策级别的图像融合,可以通过将不同来源的图像分类器的决策结果结合起来完成。以下是一个简单的例子,演示如何融合两个二分类器的决策结果:

% 假设我们有两个决策向量,分别代表两个图像的分类结果decisions1 = [0.1, 0.2, 0.7, 0.5, 0.3, 0.9]; % 图像1的决策结果decisions2 = [0.4, 0.6, 0.4, 0.8, 0.6, 0.5]; % 图像2的决策结果% 定义类别标签labels = [1, 2];% 对于每个样本,融合两个决策结果fusedDecisions = zeros(length(decisions1), 1);for i = 1:length(decisions1) % 计算每个类别的总决策分数 scores = [sum(decisions1(1:i)), sum(decisions2(1:i))]; % 确定最大分数对应的类别 [maxScore, maxIndex] = max(scores); % 如果两个图像在该样本上的决策不一致,则标记为未知 if maxScore == scores(1) && maxScore == scores(2) fusedDecisions(i) = NaN; else fusedDecisions(i) = labels(maxIndex); endend% 显示融合后的决策结果disp(fusedDecisions);在这个例子中,我们有两个决策向量,每个向量包含了两个图像分类器的决策结果。我们对每个样本的决策进行累加,并找出分数最高的类别。如果两个图像在该样本上的决策不一致,则将该样本标记为未知(使用NaN表示)。

请注意,这只是一个简单的决策融合例子。在实际应用中,决策融合可能会更加复杂,并且会根据具体情况采用不同的策略,比如使用不同的权重来结合不同的决策,或者使用机器学习方法来训练一个专门的融合模型。

在MATLAB中实现模型驱动级别的图像融合,通常指的是使用预先定义的物理模型或数学模型来指导融合过程,以便更好地适应特定的应用场景。以下是一个基于光学模型的图像融合示例,该模型用于模拟夜视图像的融合:

% 读取两个输入图像image1 = imread('image1.jpg');image2 = imread('image2.jpg');% 将图像转换为灰度(如果它们不是灰度的)if size(image1, 3) == 3 image1 = rgb2gray(image1);endif size(image2, 3) == 3 image2 = rgb2gray(image2);end% 转换为双精度浮点数image1 = double(image1);image2 = double(image2);% 定义融合模型参数(根据实际情况调整)lambda = 0.5; % 融合系数gamma = 1.5; % 对比度调节因子% 根据模型驱动的方法进行图像融合% 这里使用简单的线性组合作为融合模型,实际模型可能更复杂fusedImage = lambda * image1 + (1 - lambda) * image2;% 调整图像对比度fusedImage = (fusedImage / max(fusedImage(:))) .^ gamma;% 可视化结果figure;subplot(1, 2, 1);imshow(image1);title('Image 1');subplot(1, 2, 2);imshow(image2);title('Image 2');subplot(1, 2, 3);imshow(uint8(fusedImage * 255));title('Fused Image');在这个示例中,我们使用了一个简单的线性组合模型来融合两个图像,其中lambda是控制融合程度的比例系数,而gamma是用于调节融合后图像对比度的因子。这个模型可以适用于某些夜视图像融合的场景,其中可能需要根据环境亮度调整图像的融合比例和对比度。

请注意,这个模型是非常基础的,实际应用中可能需要更复杂的模型,例如考虑光照变化、阴影效果、颜色校正等因素。模型驱动的图像融合通常需要针对特定的应用场景进行定制开发。

在MATLAB中实现深度学习图像融合,可以使用预训练的卷积神经网络(CNN)来提取图像的特征,并通过自定义的网络结构来融合这些特征。以下是一个使用MATLAB深度学习工具箱进行图像融合的步骤:

准备数据:首先需要准备好要融合的图像数据集。

加载预训练模型:可以选择一个适合图像处理的预训练模型,如VGG16、ResNet等。

提取特征:使用预训练模型提取每张图像的特征图。

融合特征:设计一个简单的网络结构来融合特征图,例如通过加权求和或者拼接的方式。

重建图像:使用融合后的特征图来重建最终的融合图像。

可视化和评估:可视化融合结果,并进行质量评估。

下面是一个简化的MATLAB代码示例,演示了如何使用预训练的AlexNet模型来提取特征并进行简单的加权平均融合:

% 引入深度学习工具箱try vl_setupnn;catch ME rethrow(ME);end% 预加载的模型net = vl_simplenn('alexnet');% 读取图像image1 = imread('image1.jpg');image2 = imread('image2.jpg');% 预处理图像,转换为均值为0的图像meanIm = imread('image_mean.jpg'); % 假设有一个图像用于计算均值image1 = image1 - repmat(double(meanIm), size(image1, 1), 1);image2 = image2 - repmat(double(meanIm), size(image2, 1), 1);% 归一化图像至[-1, 1]image1 = double(image1) / 127.5 - 1;image2 = double(image2) / 127.5 - 1;% 将图像展平成矩阵image1 = permute(image1, [3 2 1]);image2 = permute(image2, [3 2 1]);% 提取特征features1 = vl_nnconv(image1, net, [], [], 0);features2 = vl_nnconv(image2, net, [], [], 0);% 定义融合权重(根据需要调整)weights = [0.5, 0.5, 0.5, 0.5, 0.5, 0.5]; % 假设对每一层都使用相同的权重% 融合特征fusedFeatures = features1 * weights;fusedFeatures = fusedFeatures + features2 * (1 - weights);% 重建融合图像fusedImage = reshape(fusedFeatures, size(image1, 2), size(image1, 3), size(features1, 2));fusedImage = permute(fusedImage, [2 1 3]);fusedImage = (fusedImage + 1) * 127.5;% 反量化和反归一化fusedImage = imaddcmap(fusedImage, meanIm);fusedImage = im2uint8(fusedImage);% 可视化结果figure;subplot(1, 2, 1);imshow(image1);title('Image 1');subplot(1, 2, 2);imshow(image2);title('Image 2');subplot(1, 2, 3);imshow(fusedImage);title('Fused Image');在这个例子中,我们使用了AlexNet模型来提取两幅图像的特征,并对这些特征进行加权平均融合。然后,我们重新构建融合后的图像,并进行可视化。需要注意的是,这里提供的融合权重非常简单,实际应用时可能需要根据具体任务来调整权重或者设计更复杂的融合网络结构。此外,根据所选用的模型和图像数据,可能还需要进行额外的预处理步骤。

请注意,实际应用中可能需要更复杂的算法,以处理不同类型的图像和融合场景。